I. INTRODUCCIÓN

La inteligencia artificial (IA) es un conjunto heterogéneo de tecnologías que pretenden emular las capacidades humanas para el desarrollo de tareas que, hasta su surgimiento, eran propias y exclusivas de los seres humanos (Abbott y Sarch, 2019, p. 329; 2020, p. 179; Barfield y Pagallo, 2020, p. 1; Fierens et al., 2021, p. 51)1. Tales capacidades se refieren, principalmente, a la percepción del mundo, la comprensión e interpretación de este, el raciocinio, la argumentación y la creatividad. Dentro de este contexto se inscribe la inteligencia artificial generativa (IAG), que es un enfoque tecnológico que consiste en «el aprendizaje por máquinas no-supervisado o semisupervisado para crear nuevo contenido, incluido, pero no limitado, a imágenes digitales, vídeo, audio, texto o código» (Hu, 2022). Los modelos generativos «se definen como métodos o técnicas que son capaces de transformar información en código o un subconjunto de códigos desde el que se puede reconstruir la información» (Abukmeil et al., 2021, p. 2). La IAG se ha desarrollado en torno a dos marcos preferentes: Generative Adversarial Network (GAN) (Albahar y Almalki, 2019, p. 3245; Caldera, 2019, p. 181; Raj et al., 2022, p. 181) y Generative Transformer (Dale, 2021; Hu, 2022). El primero se puede emplear, por ejemplo, en la generación de imágenes y vídeos digitales, y, con ellos, en usos como las deepfakes2; el segundo, ha permitido desarrollar los chats conversacionales de generación de contenido como ChatGPT (Generative Pre-trained Transformer) de OpenAI o BERT (Bidirectional Encoder Representations from Transformers) de Google.

Las tecnologías generativas -cuyo desarrollo fue posible gracias al avance en redes neuronales y aprendizaje automático (machine learning)- están diseñadas para ejecutar tareas que, generalmente, incluyen resumir o sintetizar textos, traducir automáticamente o generar diálogos, preguntas o paráfrasis; generar texto desde información numérica o estructurada (como tablas) o desestructurada; o generar texto desde multimodalidad, como la conversión de imágenes o vídeos en textos en lenguaje natural (Azaria, 2022; Li et al., 2022) o viceversa. Dentro de esas tecnologías, los Modelos de Lenguaje (ML)3 son aplicaciones informáticas, que pueden estar basadas en IA y que generan contenidos expresados en imágenes digitales (fotografías o vídeos) o en lenguaje natural, esto es, de la misma forma en la que los seres humanos usamos el lenguaje; en este último caso, es difícil o prácticamente imposible para un lector humano determinar si un contenido fue generado por una máquina.

En el caso de ChatGPT, uno de los ML más famosos y difundidos, el usuario puede entablar con la aplicación una interacción que emula una «conversación»; de ahí su descripción como «chat conversacional». En tal interacción, el usuario introduce un requerimiento (script) y obtiene una respuesta del chat, similar en forma y estructura a la que podría obtenerse de un interlocutor humano. ChatGPT es capaz no solo de incluir elementos de hecho y datos en sus respuestas, sino también de modificar sus respuestas sobre la base de nuevos inputs proporcionados por el usuario. La amplia difusión de esta aplicación, su inmediata disponibilidad para uso por cualquier usuario con conexión a internet y la generación de ingentes volúmenes de investigación sobre ella justifican que en este artículo me refiera principalmente a ChatGPT. No obstante, los riesgos que se identifican son válidos, en general, para las tecnologías y aplicaciones de generación automatizada de contenido digital. Si se busca ampliar el tema, Gozalo-Brizuela y Garrido-Merchán (2023) hacen una revisión sobre el estado del arte en materia de tecnologías generativas.

Como generalmente ocurre con los avances tecnológicos, las aplicaciones generativas ofrecen innumerables ventajas4; pero, a la vez, imponen desafíos y representan riesgos que hacen imprescindible conocer y gestionar adecuadamente tales herramientas. El nacimiento de tecnologías generativas basadas en IA ha provocado alarmas en el mundo académico, prediciéndose el fin de la docencia como la conocemos hoy (Crawford et al., 2023).

Este artículo se presenta como una primera aproximación a su objeto de análisis y abre una nueva línea de investigación de mi parte. Por esa razón, debe ser visto como una exposición descriptiva del fenómeno y, a la vez, un intento de revisión de la literatura sobre la materia. En ese contexto, tiene como objetivos describir los riesgos que representa para la integridad académica el desarrollo de tecnologías generativas basadas en IA y proponer algunas medidas de mitigación que se pueden adoptar para hacer frente a tales riesgos. En términos de la relevancia para este estudio, las tecnologías de generación de texto son capaces no solo de generar abstracts o sintetizar fuentes bibliográficas, sino también de escribir ensayos, artículos o tesis. Además, tienen la capacidad de responder preguntas incluidas en un examen, ya sea que estas estén expresadas en formato de selección múltiple o de desarrollo. Se ha sostenido que ChatGPT «puede generar, incluso en su estado básico, estudios de investigación de apariencia plausible para revistas bien ranqueadas» (Dowling y Lucey, 2023).

La enseñanza del derecho es especialmente vulnerable ante estas tecnologías. Los objetos de estudio de esta carrera se expresan en ideas abstractas que se fundamentan en datos de la realidad (como normas, evolución histórica de las instituciones, conflictos sociales, soluciones de aplicación de normas a hechos de la realidad, etc.). Ese escenario es propicio para el uso (y abuso) de tecnologías generativas. En consecuencia, el foco de este artículo estará puesto en la docencia universitaria en la carrera de Derecho; sin embargo, ello no obsta a que los problemas que aquí se describen pueden ser extrapolables a otras áreas del conocimiento. Además, esta contribución puede servir como base para una -a mi juicio- necesaria discusión sobre estas temáticas que debe verificarse en las universidades.

En el apartado II expondré el contexto fáctico del objeto de estudio de este artículo, en el que haré una breve exposición sobre las aplicaciones de tecnologías algorítmicas de escritura y de generación de contenido, y los usos que puede dárseles en el ámbito del desempeño académico de estudiantes universitarios. El apartado III contiene una delimitación conceptual sobre la integridad académica con el objeto de precisar su contenido y, de esa forma, obtener elementos relevantes para el apartado IV. En este último hago una descripción de las conductas que se consideran disvaloradas desde la perspectiva de la integridad académica, distinguiendo entre plagio, suplantación de autoría y simulación de autoría. Asimismo, en el apartado V propongo una taxonomía de los riesgos que las tecnologías generativas representan para la integridad académica. Esta clasificación distingue entre riesgos procedimentales -excesiva dependencia y confianza en la AIG, irrealizabilidad del modelo pedagógico o formativo, e incorporación al aprendizaje de sesgos y discriminaciones- y riesgos de resultado -responsabilidad legal, aprendizaje distorsionado, sesos y discriminación, sobrecalificación infundada, pérdida de competitividad de la institución de educación superior, contaminación de la cultura académica y degradación del valor ético de la institución-. En el apartado VI propongo cuatro medidas de mitigación de los riesgos previamente identificados en el apartado V -adaptación de los marcos normativos universitarios, revaloración del pensamiento crítico, cambios en los paradigmas de docencia y evaluación, y cuestionamiento de los entornos pedagógicos asincrónicos y a distancia-. El apartado VII, por último, está destinado a las conclusiones.

II. APLICACIONES DE GENERACIÓN AUTOMÁTICA DE LENGUAJE NATURAL

Las tecnologías de IAG, capaces de generar contenidos en forma autónoma y sin intervención humana directa, han registrado un avance importante en la interrelación directa con las personas. Es posible augurar que el lanzamiento de ChatGPT o Chat Generative Pre-Trained Transformer en noviembre de 2022 (Li et al., 2023), desarrollado por la empresa OpenAI y considerado «un gran avance en la tecnología de IA generativa» (Eke, 2023)5, llegue a considerarse un hito en esta materia. ChatGPT es la aplicación con el crecimiento de consumidores más acelerado de la historia6, con cien millones de usuarios registrados en dos meses desde su lanzamiento (Helberger y Diakopoulos, 2023)7. Además, ha logrado atraer la atención de legisladores8, medios de comunicación (Dale, 2021; García-Peñalvo, 2023), y académicos e investigadores, sobre todo en los aspectos éticos (Gordijn y Have, 2023). Recientemente, ChatGPT ha sido integrado con Bing, el motor de búsqueda de Microsoft, combinando las capacidades conversacionales con las de búsqueda en internet (Bing Chat); y se ha liberado una nueva versión: ChatGPT-49. ChatGPT no es el único chat conversacional (Floridi, 2023, p. 14)10, pero su lanzamiento aceleró una carrera entre las empresas tecnológicas en la materia (Höppner y Streatfeild, 2023; Rahaman et al., 2023)11.

ChatGPT es una herramienta capaz de procesar imágenes y lenguaje humano y de producir contenido. Es una interfaz conversacional en línea basada en un paradigma de modelo de generación de lenguaje preentrenado (Susnjak, 2022, p. 3; Kasneci et al., 2023)12. «Está diseñado para generar respuestas de texto similares a las humanas a la entrada del usuario en un contexto conversacional» (Aydin y Karaarslan, 2022, p. 22), con niveles crecientes de confiabilidad a medida que se va profundizando su entrenamiento, directamente proporcionales a la generalidad de la materia sobre la que se le consulte (Qin et al., 2023). ChatGPT, de uso gratuito13 a través de internet14, funciona gracias a algoritmos de deep learning, un tipo de IA. Tiene la habilidad de «comprender» las preguntas o requerimientos que se le formulen, encontrar patrones o relaciones generadas a partir de las enormes bases de datos con las que fue entrenado -y sigue siéndolo-15, y construir una respuesta escrita con diferentes niveles de corrección y precisión.

Desde la aparición pública de ChatGPT se han hecho estudios y ensayos que pretenden analizar la posibilidad de que dicha herramienta pueda generar textos académicos. Susnjak (2022) experimentó con diversas respuestas generadas por ChatGPT. Al analizarlas a la luz de los estándares intelectuales propuestos por Paul (2005), concluyó que las respuestas proporcionadas por el chat «pueden evaluarse como claras en la exposición, precisas con respecto a los ejemplos utilizados, relevantes para las preguntas formuladas y suficientemente profundas y amplias considerando las restricciones impuestas y lógicamente coherentes en textos más extensos» (p. 13). Jabotinsky y Sarel (2023) condujeron un experimento en el que requirieron a ChatGPT que generara texto, incluyendo referencias bibliográficas, sobre los riesgos de la IA en la producción científica. Los autores lograron determinar que el chatbot fue capaz de generar textos con sentido y bien escritos. Sin embargo, detectaron errores en las referencias bibliográficas proporcionadas (algunas de ellas, inexistentes) y destacaron que la información con la que ha sido entrenado solo comprende hasta 2021. A pesar de los defectos, los autores concluyen que ChatGPT tiene un potencial útil para la escritura académica. Asimismo, los autores sometieron a prueba a Bing y encontraron que este chatbot generó información menos específica y utilizó fuentes de información generales (como blogs) que no califican como fuentes válidas de información para un paper académico.

Bommarito y Katz (2022) condujeron una evaluación experimental de ChatGPT-3 (la versión previa a ChatGPT) que consistió en aplicarle una prueba de acceso a la barra de abogados en Estados Unidos. Los autores descubrieron que el rendimiento de ChatGPT en resolver esos exámenes se ubicó muy por encima del margen de aleatoriedad en los resultados y que superó el porcentaje de aprobación en dos de las materias incluidas en la evaluación (derecho de daños y de evidencia). También hallaron que tuvo un rendimiento muy similar al de postulantes humanos. Carrasco et al. (2023) sometieron a ChatGPT al examen MIR 2022 en España y concluyeron que, de acuerdo con el puntaje obtenido en tal examinación, el chatbot de OpenAI podría «haber elegido múltiples especialidades en distintos hospitales a lo largo del Estado» español. Choi et al. (2023), haciendo un ensayo similar, determinaron que ChatGPT habría aprobado los exámenes finales de las cuatro asignaturas que incluyeron en su estudio, obteniendo una calificación C+ en todas ellas; y que «si dicho desempeño fuera constante en toda la carrera de derecho, las calificaciones obtenidas por ChatGPT serían suficientes para que se graduara».

En el proceso de redacción de este artículo, desarrollé un pequeño ensayo solo para ilustrar el rendimiento de ChatGPT y sin pretender que sus resultados sirvan como evidencia porque no apliqué una metodología específica. Le formulé a ChatGPT sesenta de las preguntas del Modelo de Prueba PDT de acceso a las universidades chilenas para las asignaturas de Historia y Ciencias Sociales publicado por Demre, tal como aparecen escritas en el modelo. La aplicación reconoció el formato de selección múltiple de las preguntas, ya que en sus respuestas indicó cuál de las alternativas era la correcta; pudo completar cuadros de información (como en la pregunta N.° 27 del modelo); fue capaz de interpretar diagramas presentados en el modelo gráficamente, pero introducidos a ChatGPT solo con texto (como en las preguntas N.° 34, 40, 49 y 51); realizó ejercicios de comprensión lectora (preguntas N.° 9, 23, 29, 30, 32, 44, 47, 48, 50 y 55); y pudo prescindir de gráficos de información incluidos en el modelo de prueba, pero indicando la fuente de los datos (preguntas N.° 20 y 58). Al comparar las respuestas entregadas por ChatGPT16 con las claves publicadas por Demre (2022), ChatGPT acertó en cincuenta y cinco de las sesenta preguntas formuladas; esto es, tuvo un 91,7 % de acierto. Esto significa que, de haber rendido la examinación, ChatGPT habría obtenido ochocientos ochenta y ocho puntos de un total de mil.

En el mundo del derecho, y a pesar de su enfoque generalista, ChatGPT ya ha tenido usos concretos en la función jurisdiccional. Este chatbot fue utilizado por un tribunal colombiano como apoyo en la construcción de fundamentos jurídicos en el dictado de una de sus sentencias17.

Floridi (2023) explica los Modelos de Lenguaje comparándolos por analogía con los loros estocásticos, pero advirtiendo brillantemente que

La analogía ayuda, pero solo en parte, no solo porque los loros tienen una inteligencia propia que sería la envidia de cualquier IA sino, sobre todo, porque los [Modelos de Lenguaje de Gran Tamaño] sintetizan textos de nuevas formas, reestructurando los contenidos en los que han sido entrenados, no proporcionando simples repeticiones o yuxtaposiciones. Se parecen mucho más a la función de autocompletar de un motor de búsqueda. Y en su capacidad de síntesis se asemejan a esos alumnos mediocres o perezosos que, para escribir un breve ensayo, utilizan una decena de referencias pertinentes sugeridas por el profesor y, tomando un poco de aquí y un poco de allá, arman un texto ecléctico, coherente, pero sin haber entendido mucho ni añadido nada. Como tutor universitario en Oxford, corregí muchos de ellos cada trimestre. Ahora ChatGPT puede producirlos de manera más rápida y eficiente (p. 15).

Estas tecnologías ofrecen oportunidades únicas para el mejoramiento continuo de la enseñanza universitaria que «incluyen una mayor participación, colaboración y accesibilidad de los estudiantes» (Cotton et al., 2023). Pueden permitirles identificar fuentes de información de una manera más rápida que a través de las búsquedas en bases de datos convencionales, facilitarles el procesamiento de mayores volúmenes de datos para discriminar los relevantes de los accesorios o contribuir al proceso de formación de un juicio crítico sobre diversos temas, por mencionar algunos aspectos. Pero estas tecnologías también plantean desafíos (Islam y Islam, 2023; Kasneci et al., 2023; Riley y Alvarez, 2023), entre ellos uno de carácter ético e, incluso, jurídico que se relaciona con lo que en términos coloquiales denominamos «copia».

La versión 3.5 de ChatGPT disponible en forma gratuita se diferencia de todas las otras aplicaciones generativas y conversacionales existentes, incluso de sus propias versiones previas18, por las capacidades que dicho chatbot tiene. No solo puede entender texto natural y contestar preguntas, sino que también es capaz de traducir entre distintos idiomas, rechazar requerimientos inapropiados, contradecir premisas incorrectas, resumir textos, generar escritura creativa como poesía, contar chistes o crear cuentos (Eke, 2023; Jiao et al., 2023; Talan y Kalinkara, 2023, p. 35). Y se encuentra aún en su infancia. Como lo han destacado Aljanabi y ChatGPT (2023, p. 16) -¡sí, el propio chatbot es coautor declarado de esta fuente!-, «una de las direcciones futuras más prometedoras para ChatGPT es su integración con otras tecnologías de IA, tales como la visión de computadores y la robótica»19. A ello se puede agregar que ChatGPT tiene un enfoque generalista con relación a la información de entrenamiento empleada, pero nada obsta a que en un corto o mediano plazo surjan chats conversacionales entrenados en áreas específicas del conocimiento. El derecho puede ser una de ellas.

III. INTEGRIDAD ACADÉMICA

Para identificar los riesgos que las tecnologías de IA de generación de contenido representan para la integridad académica20, tomaré como referencia la definición propuesta por el International Center for Academic Integrity (2021) sin perjuicio de destacar que, a nivel de definición, un consenso sobre cómo definir la integridad académica está lejos de alcanzarse y su comprensión está fuertemente influida por contextos nacionales, como lo demuestran los diferentes trabajos que integran el Handbook of Academic Integrity (Bretag (ed.), 2016).

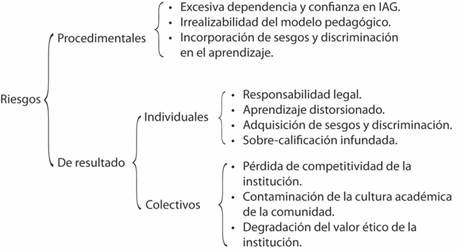

El International Center for Academic Integrity (2021) define la integridad académica como un compromiso con seis valores fundamentales: honestidad, confianza, justicia, respeto, responsabilidad y coraje (ver Figura 1).

Fuente: International Center for Academic Integrity (2021).

Figura 1 Esquema de los valores que integran el concepto de integridad académica

Desde una perspectiva deontológica, la adhesión sustancial a estos valores permite reconocer una actividad académica como tal en la medida que la adecuación a tales valores es un requisito de la esencia de las labores de docencia e investigación. Desde un enfoque ético utilitarista, la recepción de los señalados valores permite atribuirle valor y credibilidad a la actividad académica.

El International Center for Academic Integrity (2021) estima que el valor de la honestidad se encuentra en la base de los valores de la confianza, la justicia, el respeto y la responsabilidad, actuando como un sustrato necesario para el desarrollo ético. Entiende a la honestidad como aquella cualidad positiva que consiste en ser legítimo o veraz, esto es, la ausencia de fraude o engaño.

En virtud del valor de la confianza, los «miembros de la comunidad académica deben ser capaces de confiar en que el trabajo, ya sea de estudiantes o investigadores, no es falsificado y que los estándares se aplican por igual a todos» (International Center for Academic Integrity, 2021, p. 6).

El valor de justicia es definido por ICAI como aquella cualidad positiva que consiste en la «calidad o estado de ser justo, especialmente el trato justo o imparcial, la falta de favoritismo hacia un lado u otro» (International Center for Academic Integrity, 2021, p. 7). La adhesión a este valor impone el deber de un tratamiento imparcial que refuerza la importancia de la verdad, las ideas, la lógica y la racionalidad; y se manifiesta en componentes de predictibilidad, transparencia y expectativas claras y razonables (International Center for Academic Integrity, 2021, p. 7).

El valor del respeto es entendido como una alta o especial consideración o la cualidad de ser estimado. Este valor se desenvuelve en dos perspectivas. La primera, el autorrespeto, que significa enfrentar los desafíos sin comprometer los valores propios; y la segunda, el heterorrespeto, que consiste en «valorar la diversidad de opiniones y apreciar la necesidad de desafiar, probar y refinar las ideas» (International Center for Academic Integrity, 2021, p. 8).

El valor de la responsabilidad consiste en la cualidad de asumir un deber y cumplirlo, desde una perspectiva ética e, incluso, normativa (jurídica). La adhesión del valor de la responsabilidad para con uno mismo como para con los otros distribuye y aumenta la posibilidad de introducir cambios importantes en la comunidad académica (International Center for Academic Integrity, 2021, p. 9).

Finalmente, el valor del coraje significa la capacidad de cada uno de los miembros de la comunidad de actuar de acuerdo con los propios valores con fundamento, a pesar del miedo de adoptar esa posición y de comportarse de acuerdo con las propias convicciones personales. Tal actuación solo tiene protección si los valores propios tienen fundamento y son aceptados por el resto de la comunidad (International Center for Academic Integrity, 2021, p. 10).

IV. CONDUCTAS Y SU (DIS)VALORACIÓN

Desde la aparición de los programas de procesamiento de texto hemos contado con herramientas de ayuda en el proceso de escritura; por ejemplo, las funciones de corrección ortográfica y gramatical, y de autocorrección con que cuenta el procesador de texto MS Word. O los asistentes digitales de escritura (DWA, por sus siglas en inglés) que permiten introducir mejoras sustanciales a la redacción, la gramática y el vocabulario utilizado en un texto escrito. El anuncio efectuado por Microsoft sobre el lanzamiento de 365 Copilot21 promete llevar las herramientas productivas a un nivel sin precedentes.

Las utilidades existentes son herramientas cuyo uso no solo se encuentra naturalizado, sino que, además, puede ser valorado. Nadie cuestionaría a un estudiante que ha enmendado sus erratas en un ensayo o en una tesis gracias al corrector ortográfico y gramatical de MS Word; y, de hecho, lo reprochable sería que, en la redacción de un trabajo escrito, su autor incurra en tales errores por no haberlas utilizado. Los asistentes digitales de escritura, basados en IA, ayudan a superar barreras idiomáticas que pueden incrementar el acceso de personas no nativas del inglés para publicar sus investigaciones en revistas anglófonas que prácticamente monopolizan las principales vías de difusión del conocimiento, incluso en las ciencias jurídicas y criminológicas (Faraldo-Cabana, 2018, 2019; Faraldo-Cabana y Lamela, 2021). Las aplicaciones ML, a través de las funciones para las que están diseñadas, tienen un potencial enorme, cuya utilización en la docencia podría aportar gran valor.

No obstante, las herramientas informáticas también generan riesgos para la integridad académica y al propio proceso docente que es necesario identificar y mitigar. Tal tarea debe comenzar por una identificación previa respecto de las posibles conductas involucradas. No cualquier utilización de herramientas basadas en IA va a conducir, automáticamente, a conductas que pueden desvalorarse desde la perspectiva de la integridad académica. Establecer dicha relación causal sería una simplificación inadmisible.

En palabras de Eke (2023), el riesgo de las aplicaciones ML consiste en que «tanto los estudiantes como los investigadores puedan comenzar a externalizar su escritura a ChatGPT. Si algunas respuestas tempranas a las preguntas de ensayo de nivel universitario sirven de algo, los profesores deberían estar preocupados por el futuro de los ensayos como una forma de evaluación».

Me parece acertada la descripción que hace Eke porque permite distinguir dos grandes grupos de casos dentro de la utilización de tecnologías. El primero, compuesto por aquellas conductas en las que el uso de herramientas tecnológicas es irreprochable porque tal utilización no lesiona valores ni reglas; el segundo, constituido por comportamientos disvalorados porque el uso de herramientas tecnológicas infringe tales valores o normas. En este grupo, que Dawson (2021) denomina genéricamente e-cheating, el uso de las herramientas tecnológicas sobrepasa el mero apoyo o ayuda que ellas prestan. Estimo que en este grupo de e-cheating pueden reconocerse tres formas específicas de conductas disvaloradas: plagio, suplantación de autoría y simulación de autoría.

En el caso del plagio -palabra que derivaría del latín plagiare, secuestro con el propósito de convertir a la víctima en esclavo (Fishman, 2016, p. 13)-, es poco lo que puede agregarse en términos de su descripción como conducta disvalorada, a pesar de que en ella no abundan los consensos ni las definiciones precisas (Jelenic y Kennette, 2022, pp. 16-17). Según una sentencia penal dictada en Chile, el plagio es «[l] a apropiación de una obra ajena, haciéndola pasar como propia o bien utilizando los elementos creativos de aquella para la elaboración de una nueva creación de carácter ilegítima». De acuerdo con la Organización Mundial de Propiedad Intelectual (OMPI, 1980) el plagio consiste en «el acto de ofrecer o presentar como propia, en su totalidad o en parte, la obra de otra persona, en una forma o contexto más o menos alterados» (p. 192). El elemento central del plagio es la usurpación de un contenido perteneciente a otra persona que es su autora.

El plagio convencional o básico consiste en la trascripción de un contenido de autoría ajena y su atribución a una persona distinta. Aunque las tecnologías de IA pueden facilitar esta forma de plagio, es evidente que la posibilidad de incurrir en él es completamente independiente de tales tecnologías. En otras palabras, que el riesgo de plagio convencional existe con o sin tecnologías de IA e, incluso, con la misma intensidad. Con relación a las herramientas informáticas, el riesgo de plagio es especialmente relevante a propósito de las herramientas de parafraseo automático (APT, por sus siglas en inglés). El plagio puede ser facilitado sustancialmente por estas herramientas (Rogerson y McCarthy, 2017), ya que ellas permiten cambiar la estructura sintáctica y gramatical de párrafos enteros, pero adoptando las ideas contenidas en la fuente parafraseada y omitiendo la referencia a la fuente consultada. El parafraseo no es necesariamente una tarea fácil y requiere no solo de habilidades, sino también de conocimientos sobre la materia; pero las tecnologías de IA permiten a quien efectúa el parafraseo prescindir de habilidades y conocimientos para hacerlo. Esta modalidad, denominada «plagio simulado», «inteligente» o «elaborado» (Echavarría, 2014, p. 710; 2016), puede burlar fácilmente los softwares de detección de plagio.

En el entorno angloamericano se ha investigado y descrito la conducta de commercial cheating, esto es, el reclutamiento por parte de estudiantes de terceras personas que escriben por ellos o ellas sus ensayos, memorias o tesis a cambio de un pago (Newton y Lang, 2016; Newton, 2018) y que en nuestro medio se conoce como «suplantación de autoría» (Comas Forgas y Sureda Negre, 2008; Rojas Chavarro y Olarte Collazos, 2010)22. No conozco estudios que hayan determinado la incidencia de este fenómeno en Chile, pero su existencia es una cuestión conocida23. La externalización de la redacción de trabajos académicos a una aplicación de generación automática de texto funciona con la misma lógica del commercial cheating y constituye el mismo tipo de infracción a la integridad académica. No obstante, las aplicaciones de generación automática de texto pueden llevar el fenómeno a niveles sin precedentes y tienen el potencial de amenazar masivamente la forma en la que entendemos la docencia y el proceso de evaluación. En palabras de King y del propio ChatGPT (2023),

[l]os estudiantes universitarios podrían potencialmente usar ChatGPT para hacer trampa en las tareas de redacción de ensayos alimentando al chatbot con indicaciones y preguntas específicas, y luego copiando y pegando las respuestas generadas en sus propios trabajos. Esto les permitiría producir fácilmente ensayos sin poner el esfuerzo y la investigación necesarios para escribir contenido original.

No obstante el plagio y la suplantación de identidad, las tecnologías de IA analizadas en este artículo plantean un escenario diferente. En términos descriptivos, este nuevo escenario consiste en el caso de un estudiante que haya obtenido su trabajo directamente desde una aplicación de generación automática de texto, o una parte más o menos sustancial de él, pero que aparente ser su autor, sin reconocer su verdadera fuente de creación, sin referenciar el origen de los insumos para su redacción o sin declarar el método utilizado para la creación del contenido.

En este escenario, la extracción sin indicar la fuente no puede considerarse plagio porque el chatbot no es un ser humano y el plagio requiere la usurpación de la autoría de una persona (Kleebayoon y Wiwanitkit, 2023). Es cierto que el chatbot habrá tomado la información de alguna fuente bibliográfica humana, ya que su habilidad no es inventar una respuesta o generar nuevo conocimiento, sino articular una respuesta sobre la base de su información de entrenamiento. Pero, aun así, tomar la información preparada por un chatbot que proviene de fuentes «humanas» y simular ser su autor no es suficiente para considerarlo una forma de plagio propiamente tal. Asimismo, en este escenario no hay una contraprestación para el tercero que actúa como el verdadero autor del contenido; por el contrario, solo existe una relación entre el estudiante y una máquina inteligente generadora del contenido. Propongo denominar «simulación de autoría» a esta modalidad de deshonestidad académica que se desarrolla en entornos tecnológicos.

A modo de ilustración, formulé a ChatGPT el siguiente requerimiento: «Escribe un resumen sobre “Who Dares Fine a Murderer? The Changing Meaning of Money and Fines in Western European Criminal Systems”, escrito por Patricia Faraldo-Cabana» (Faraldo-Cabana, 2015). El chatbot generó la siguiente respuesta:

“Who Dares Fine a Murderer? The Changing Meaning of Money and Fines in Western European Criminal Systems” es un artículo escrito por Patricia Faraldo-Cabana que aborda el papel del dinero y las multas en los sistemas criminales de Europa occidental. El artículo examina cómo ha cambiado la percepción del dinero como una forma de compensación por el delito, desde la antigua Grecia hasta la actualidad, y cómo el uso de multas ha evolucionado en respuesta a los cambios económicos y culturales.

Faraldo-Cabana argumenta que la multa se ha utilizado históricamente como una forma de restaurar el orden social, ya que la compensación monetaria no solo compensaba a la víctima sino que también castigaba al delincuente. Sin embargo, a medida que la economía se ha vuelto más compleja, la multa se ha utilizado cada vez más como una fuente de ingresos para el estado en lugar de un castigo por el delito.

El artículo también destaca las diferencias culturales en la percepción del dinero y las multas en Europa occidental, y cómo estas diferencias han influido en la evolución de los sistemas criminales. Por ejemplo, en países como Alemania, donde se valora la idea de que la justicia no tiene precio, las multas se han utilizado con moderación, mientras que en países como España, donde las multas se han utilizado históricamente como una forma de obtener ingresos para el Estado, se han aplicado con mayor frecuencia.

En general, “Who Dares Fine a Murderer? The Changing Meaning of Money and Fines in Western European Criminal Systems” ofrece una perspectiva interesante sobre cómo la percepción del dinero y las multas ha evolucionado en los sistemas criminales de Europa occidental y cómo estos cambios han reflejado las transformaciones económicas y culturales a lo largo del tiempo24.

El texto puede considerarse una buena síntesis del artículo, pero ChatGPT erró en la identificación de la fuente25. Sin embargo, su respuesta perfectamente podría ser utilizada por un o una estudiante en la entrega de un informe o trabajo escrito evaluado.

Surge el interrogante sobre la necesidad de distinguir una forma específica de conductas disvaloradas -la simulación de autoría- si ya existen el plagio y la usurpación de autoría. Estimo que reconocer esta tercera modalidad de conducta disvalorada se justifica por las diferencias que esta tiene con relación a las otras dos modalidades.

La primera diferencia consiste en que las tecnologías de IA tienen la capacidad de conferirle a la simulación de autoría un efecto amplificador de los riesgos para la integridad académica. Si el plagio tradicional se basa en la fatídica, pero engorrosa combinación de las acciones copiar-pegar (copy-paste), las tecnologías algorítmicas de escritura y de generación de contenido que se pueden usar deshonestamente pueden serlo a una escala industrial por la facilidad de uso que ellas tienen y la posibilidad de replicar sus utilizaciones. Haciendo una analogía, el aumento de la escala de los riesgos para la integridad académica es igual al que, en su momento, representó la invención y masificación de la máquina fotocopiadora para la propiedad intelectual de los libros.

La segunda diferencia que plantean las indicadas tecnologías es que su utilización es prácticamente indetectable y, con ello, resulte imposible acreditar una conducta disvalorada. La indetectabilidad se debe a que los softwares de detección de plagio no son capaces de identificar el parafraseo hecho con herramientas algorítmicas, ni tampoco si un texto fue producido por una aplicación de generación automatizada (Rudolph et al., 2023). El profesor o profesora que evalúa un trabajo escrito tampoco está en condiciones de percibir si un texto es de autoría propia del estudiante sometido a la evaluación o fue escrito por una máquina. Se han hecho esfuerzos por desarrollar herramientas de detección (clasificación) de contenido generado automáticamente, pero sin resultados concretos por el momento (Perkins, 2023, p. 13). OpenAI, de hecho, informa en su página web que se encuentra trabajando en una aplicación denominada Classifier (Kirchner et al., 2023), que podría llegar a tener la capacidad de determinar si un texto fue escrito por una persona o fue generado por ChatGPT. Pero la empresa advierte que dicha aplicación tiene importantes limitaciones26 y que ella «[n]o debe usarse como una herramienta principal para la toma de decisiones, sino como un complemento de otros métodos para determinar la fuente de un texto» (Kirchner et al., 2023). Además, advierten los ingenieros de OpenAI, «los estudiantes pueden aprender rápidamente cómo evadir la detección modificando algunas palabras o cláusulas en el contenido generado» (Kirchner et al., 2023). La indetectabilidad también se debe a los altos costes asociados a los procesos de auditoría o investigación sobre la autoría y detección de conductas disvaloradas, que requieren de tecnologías innovadoras que no todas las universidades están en condiciones de financiar o en capacidad de acceder a ellas (Crawford et al., 2023, p. 2; Eke, 2023, p. 3; Kasneci et al., 2023, p. 13).

La característica de la indetectabilidad y la precariedad de las herramientas para contrarrestarla hacen que surja otro tipo de riesgo: la posibilidad de juzgar inadecuadamente como conducta disvalorada el comportamiento de un estudiante que no lo ha sido (falso positivo) o la de considerar como lícito el comportamiento de un estudiante que efectivamente ha sido deshonesto (falso negativo). Las tecnologías generativas pueden desencadenar un círculo vicioso de afectación al valor de la confianza como parte de la integridad académica. Por un lado, la posibilidad de su utilización por los y las estudiantes podría conducir a los y las profesoras a comenzar el proceso evaluativo desde una premisa de desconfianza, es decir, desde una situación inicial de negación de dicho valor. Por otro lado, la urgencia por detectar y evitar conductas disvaloradas plantea el riesgo de instalar culturas de vigilantismo al interior del proceso docente que también implican una afectación al valor de la confianza como elemento estructurante de la integridad académica27.

La tercera diferencia consiste en el carácter informatizado de las técnicas de deshonestidad que el mal uso de las tecnologías de IA permite desarrollar (Dawson, 2021, pp. 5-6). Esto significa que, en tanto los métodos «tradicionales» responden a experiencias individuales difícilmente compartibles con otros en términos de sus productos, las tecnologías están ampliamente disponibles, son transables, distribuibles y accesibles para casi cualquier usuario que disponga de una conexión a internet y un dispositivo que le permita navegar por ella. En otras palabras, las técnicas de deshonestidad tecnologizadas dejan de ser una experiencia individual y pueden pasar a tener un carácter colectivo que llegue a muchas personas instantáneamente.

V. RIESGOS

La identificación de los riesgos éticos, su evaluación y mitigación son áreas que han adquirido especial relevancia a propósito de la energía que ha mostrado el desarrollo de la IA después de su segundo invierno (Boddington, 2017; Bryson, 2020; Donath, 2020; Eitel-Porter, 2021; Felländer et al., 2022; Hagendorff, 2020, 2022; Hermansson & Hansson, 2007; Powers & Ganascia, 2020; Siau & Wang, 2020; Spivak & Shepherd, 2021; Vanem, 2012; Yapo & Weiss, 2018). En general, se destacan los riesgos que plantea la IA para la vigencia de los derechos fundamentales (Council of Europe, 2018; Yeung, 2019), o para la decisión y ejecución de políticas públicas, que podrían imponer una algocracia (Danaher, 2016, 2022; Chace, 2018, pp. 89 y ss.; Gritsenko y Wood, 2020; Chomanski, 2022), entre otros tópicos. En particular, los riesgos para la integridad académica también han despertado la atención científica y académica (Abdelaal et al., 2019; Jabotinsky & Sarel, 2023; Lancaster, 2021; Moya et al., 2023; Perkins, 2023; Roe & Perkins, 2022).

Los riesgos deben ser entendidos como amenazas que pueden llegar a concretarse en daños o afectaciones efectivas; en el caso del objeto de este artículo, para la integridad académica. Es decir, que la IA tiene ciertas condiciones que, en determinadas circunstancias, representan una potencial agresión a los valores sobre los que se estructura la integridad académica.

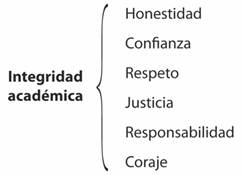

La identificación de los riesgos de la IA en la docencia superior requiere reconocer que ella tiene una doble dimensión. Por un lado, es un proceso continuo de carácter dinámico que se va desenvolviendo en el tiempo y en el que se van verificando hitos; y, por otro, es un resultado, una situación final a la que se llega. Por ello, he identificado dos grandes grupos de riesgos: los procedimentales, que refieren a las amenazas sobre la docencia entendida como proceso; y los de resultado, es decir, los peligros de la IA que impactan el producto final del proceso de docencia28. Un esquema de los riesgos identificados se muestra en la Figura 2.

No es posible en esta oportunidad hacer una descripción detallada de cada uno de los riesgos identificados porque dicha empresa excedería la extensión de un artículo. Por ello, formularé una enunciación de tales riesgos, dejando la posibilidad de su desarrollo para futuras investigaciones.

V.1. Riesgos procedimentales

V.1.1. Excesiva dependencia y confianza en la AIG

La excesiva dependencia y confianza en la AIG es una forma de riesgo o amenaza que puede describirse sobre la base de dos parámetros: dependencia y confianza, y que se produce cuando estos superan un umbral en la interacción usual de los usuarios con la tecnología, de la misma forma en que una afición se transforma en una adicción. En el primer parámetro, enfocado en la dependencia, el riesgo surge cuando los estudiantes -pero también profesores- adquieren conductas en el proceso de aprendizaje que transforman a las tecnologías de IAG en elementos imprescindibles del proceso, ante cuya ausencia el desarrollo de sus acciones propias no pueda llevarse a cabo. En el segundo parámetro, el de la confianza, el riesgo se manifiesta cuando el usuario adquiere la convicción de que la información o contenidos generados por la IAG son necesariamente autosuficientes y correctos, renunciando a una posición crítica sobre ellos.

Aunque las tecnologías de IA son cautivadoras, tanto porque sorprenden como porque facilitan el trabajo, no debe olvidarse que los contenidos generados por la IAG no están -ni pueden estar- libres de errores u omisiones. Se ha detectado que ChatGPT presenta fallas de sentido común (Ji et al., 2023) y no está aún preparado para proporcionar pruebas matemáticas o cálculos de alta calidad de manera consistente (Frieder et al., 2023). Los errores en IAG corresponden a los fenómenos que los expertos denominan «alucinación» -información generada sin base fáctica- y «divergencia» -fragmentos desalineados de la información de entrenamiento- (Xiao y Wang, 2021; Rebuffel et al., 2022, p. 319; Bang et al., 2023; Ji et al., 2023). Los errores y los déficits de confiabilidad que presenta la IAG, como en el caso de ChatGPT, no la transforman en una herramienta inútil, a juicio de Dale, sino que todo depende de para qué se use.

En consecuencia, así como no puede pretenderse, por ejemplo, obtener del chatbot consejos médicos porque sus errores pueden poner en riesgo la salud de personas (Dale, 2021), apoyar todo el proceso de enseñanza en esas herramientas también es desaconsejable. La excesiva dependencia y confianza en la IAG se presenta como un riesgo para a los valores de honestidad y confianza que configuran la integridad académica. Si los estudiantes desarrollan una relación de dependencia con la IAG al nivel descrito, están renunciando al proceso mismo de aprendizaje y ello puede conducir a actos que afecten la honestidad, no solo por la posible realización de las conductas disvaloradas como la simulación de autoría, sino también por la misma renuncia de los estudiantes a su rol de protagonistas de su propio aprendizaje. En consecuencia, el resto de la comunidad académica, y principalmente los profesores, dejarán de confiar en sus estudiantes sobre el grado de aprendizaje que estos estén adquiriendo, lo que afectaría a la confianza como valor. Indirectamente, ello puede conducir a afectaciones a valores de la integridad académica como la justicia y el respeto.

V.1.2. Irrealizabilidad del proyecto pedagógico

La utilización masiva, descontrolada y sin supervisión de IAG puede poner en riesgo la «realizabilidad del proyecto pedagógico» de una institución de educación superior. Este riesgo es especialmente fuerte en aquellas instituciones que han optado por modelos pedagógicos basados en el desarrollo de competencias o de resultados de aprendizaje. El mal uso (y abuso) de las tecnologías de IAG puede llevar a que los estudiantes no logren el desarrollo de las competencias o de los aprendizajes esperados. En un escenario -espero- distópico en esta materia, los estudiantes pueden transformarse en meros operadores de máquinas generadoras de información, pero sin que logren una comprensión ni un análisis crítico, incapaces de construir su propio conocimiento y de generar otros nuevos.

Este riesgo de irrealizabilidad amenaza indirectamente los valores de la integridad académica, ya que una institución incapaz de concretar sus propios objetivos en docencia podría generar una cultura en la que nada importe, con los valores de la integridad académica como los primeros candidatos a dicha indiferencia.

V.I.3. Incorporación de sesgos y discriminación en el aprendizaje

Uno de los principales problemas de la IA en general, y en particular de las tecnologías generativas, es la existencia en ellas de sesgos y criterios de discriminación -arbitraria- provenientes de la información utilizada en sus procesos de entrenamiento (Bender et al., 2021, pp. 613 y ss.; Weidinger et al., 2021, pp. 9-18) y de su propio desarrollo. Así, la inclusión y la diversidad son factores que se consideran necesarios para el desarrollo de una IA ética (Dignum, 2019, pp. 100-101). Los sesgos y la discriminación son los presentes en la sociedad y en la información con la que son entrenadas las herramientas de IA, o los de los propios programadores de las aplicaciones (Whitby, 2011, p. 143). El uso de tales herramientas, en consecuencia, produce el riesgo de que los estudiantes incorporen en su proceso de aprendizaje tales sesgos y criterios de discriminación. Es cierto que las visiones sesgadas y discriminatorias parecen ser propias del ser humano, lo que significa que tales sesgos y discriminaciones también estarán presentes en la enseñanza y el aprendizaje sin el uso de IAG. Pero si esa condición es propiamente humana, parece que estamos en la necesidad de tolerar ciertos márgenes «naturales» de sesgos y discriminación, al punto de que hemos desarrollado mecanismos para detectarlos y, en lo posible, superarlos. Una cuestión distinta es que sea conveniente que aceptemos (o tengamos que aceptar) los que provienen de máquinas. El riesgo se hace más intenso si se considera el black box effect propio de la IA, una característica de complejidad de las tecnologías de deep learning que hace imposible reconstruir los procesos que ejecutó la máquina para llegar al resultado que entrega, lo que prácticamente atribuye a sus resultados un carácter inescrutable. «El peligro está en crear y usar decisiones que no son justificables, legitimables o que simplemente no permiten obtener explicaciones detalladas de ese comportamiento» ejecutado por la máquina (Barredo Arrieta et al., 2020, p. 83).

El aprendizaje mediado por errores, sesgos o discriminaciones afecta directamente la honestidad. Los miembros de la comunidad académica que aprenden bajo esas condicionantes no podrán ser honestos y, de hecho, ni siquiera estarán en condiciones de percibir sus propios errores. Pero también amenaza la confianza entre los distintos miembros de la comunidad, presentando un escenario propicio para una pérdida del respeto, otro de los valores amenazados.

V.2. Riesgos de resultado individuales

V.2.1. Responsabilidad legal

Dentro de los riesgos de resultado de carácter individual se encuentra el de sufrir consecuencias o responsabilidades legales.

Las conductas disvaloradas antes mencionadas (plagio y suplantación y simulación de autoría) pueden llevar a que la persona que incurra en ellas infrinja normas jurídicas universitarias o administrativas por las que puede ser sancionada, produzca un daño a terceros que deba indemnizar o cometa un delito que le haga penalmente responsable. Asimismo, esas conductas pueden llegar a comprometer la responsabilidad civil o administrativa de la propia institución universitaria por infringir los deberes de supervisión sobre sus propios estudiantes, al permitir que esas conductas disvaloradas se ejecuten o por no adoptar medidas de prevención adecuadas para impedirlas.

La presencia de conductas disvaloradas pueden hacer que sus protagonistas intenten evadir los mecanismos de control para evitar sufrir las consecuencias legales. El éxito de estas maniobras de evasión afecta directamente los valores académicos de justicia y responsabilidad. Por otro lado, un sistema eficaz de control y supervisión que sea capaz de reprimir estas conductas puede conducir a otros riesgos, como la irrealizabilidad del modelo pedagógico.

V.2.2. Aprendizaje distorsionado y adquisición de sesgos y discriminaciones

De igual forma, el mal uso de herramientas de IA puede conducir a un aprendizaje distorsionado, ya sea porque el/la estudiante adquirió información incorrecta, sesgada o discriminatoria; porque no internalizó esa información y, por tanto, es incapaz de procesarla; o porque las mejoras que el o la estudiante introdujo pueden no reflejar su conocimiento como autor de un texto escrito y corregido automáticamente (Perkins, 2023). La sobreutilización de herramientas de IA como fuente de información o como instrumentos para «hacer el trabajo», la no contrastación con otras fuentes y la ausencia de análisis crítico pueden llevar a que el aprendizaje logrado se encuentre completamente distorsionado por los sesgos y la discriminación presente en la IA.

Cabe subrayar que un aprendizaje distorsionado o sesgado afecta directamente los valores de integridad académica de honestidad, confianza y respeto.

V.2.3. Sobrecalificación infundada

El uso de tecnologías algorítmicas de generación de texto y contenido puede conducir a que los ensayos, memorias o tesis -en general, las evaluaciones escritas- arrojen un rendimiento asimétrico con las competencias desarrolladas o los aprendizajes obtenidos; en otras palabras, a una sobrecalificación que carezca de fundamento fáctico en términos del real aprendizaje del/la estudiante.

La conducta de mejorar el rendimiento numérico en las evaluaciones -notas o calificaciones- usando deshonestamente la tecnología introduce, como es evidente, un elemento de injusticia. Tales conductas aumentan la probabilidad de una mejor calificación con una fracción del esfuerzo que otro/a estudiante honesto/a puso en la realización de la misma tarea sometida a evaluación. El subsidio que el uso deshonesto de la tecnología puede producir es una amenaza al valor de justicia que forma parte de la definición de integridad académica. Aunque el proceso de evaluación es el mismo para todos los estudiantes, el uso fraudulento de tecnología no está considerado dentro de los criterios evaluativos y hace que se obtenga la misma evaluación -o mejor- con menos esfuerzo que quien se empeñó más.

V.3. Riesgos de resultado colectivos

V.3.1. Pérdida de competitividad de la institución

En la esfera de los riesgos de resultado de carácter colectivo, la utilización indebida de tecnologías de IA puede llegar a amenazar la competitividad de una institución de educación de superior. Una universidad en la que el uso de tales prácticas incorrectas se masifique y no se adopten medidas de mitigación puede ver afectada la competitividad de sus titulaciones, tanto por una cuestión de imagen pública como por la menor calidad de los profesionales que egresen de ella.

V.3.2. Contaminación de la cultura académica

La difusión de prácticas deshonestas y su falta de represión puede hacer que estas terminen naturalizándose y normalizándose. Este proceso sostenido en el tiempo, que permite que las prácticas deshonestas se naturalicen y normalicen, deteriora y contamina la cultura académica de una institución universitaria. La contaminación se manifiesta en el desapego de sus miembros a los valores de integridad académica y, con ello, en la renuncia a los valores que esta implica.

V.3.3. Degradación del valor ético de la institución

El proceso de degradación a que puede conducir una cultura académica contaminada puede generar, finalmente, una pérdida del valor ético de tal institución. El valor ético -esto es, el fuerte compromiso real y material con la integridad académica- es una condición que debería ser considerada como el principal activo intangible en una universidad. La pérdida de competitividad y la degradación de su valor ético muestra un escenario profundamente perverso, caracterizado por la negación de la integridad académica.

VI. MEDIDAS DE MITIGACIÓN

Los desafíos que plantea la IA29 en la actividad docente universitaria conducen la mirada a lo que se ha descrito como la destreza digital (digital dexterity); esto es, la «capacidad de autoorganizarse rápidamente para ofrecer un nuevo valor a partir de las tecnologías digitales» (Soule et al., 2016, p. 5). Me parece razonable que, frente a las nuevas realidades que se están construyendo a partir de los desarrollos tecnológicos, las universidades adopten una actitud de reconocimiento hacia ellas e inicien un proceso de reflexión que les permita obtener los beneficios que tales tecnologías ofrecen, aprovechándolos para diseñar y aplicar en forma efectiva medidas que mitiguen los riesgos que ellas plantean. Estas tareas deberían ser asumidas con un sentido de urgencia atendida la velocidad con la que la tecnología se desarrolla30.

En este sentido, creo necesario explorar cuatro medidas de mitigación de los riesgos antes descritos: la adaptación de marcos normativos, la revalorización del pensamiento crítico, los cambios en los paradigmas de la docencia y el cuestionamiento de los modelos de e-learning. A continuación, se ofrece una breve explicación de ellas.

VI.1. Adaptación de los marcos normativos

El normativo es uno de los elementos que conforman una organización. Las normas son mandatos de comportamiento que poseen ciertas características que las hacen importantes, a saber: a) tienen la capacidad de aumentar la predictibilidad de los comportamientos de los otros -que no es lo mismo que pretender que las normas determinen comportamientos ajenos-; b) guían la selección de comportamientos que efectúan las personas, ya que las normas indican qué es lo esperable y qué no; c) obligan a mejorar la coordinación entre personas colaboradoras en un proyecto o tarea común (Malle et al., 2017, pp. 4-5); y d) tienen una cierta capacidad para motivar el comportamiento de las personas, mostrando la trascendencia de los intereses relevantes a proteger, en los que se denominan los efectos expresivo-integradores de las normas (Díez Ripollés, 2003, p. 151).

La adaptación de los marcos normativos como medida de mitigación consiste en que las universidades inicien un proceso interno de discusión que lleve a una adaptación de sus normas internas a las nuevas realidades marcadas por la IA. Se trata de que las reglamentaciones estén construidas considerando estos nuevos riesgos para evitar vacíos normativos que hagan que, frente a una conducta disvalorada, esta deba ser sancionada aun en ausencia de norma -afectando la predictibilidad requerida de las normas- o que no pueda ser sancionada por ausencia de normativa que lo permita, afectando la vigencia de valores de integridad académica. En este sentido, la adaptación de los marcos normativos pasa por la incorporación de una regulación especialmente diseñada para lo que aquí he denominado «simulación de autoría».

Además de verificar que las normas contemplen los nuevos escenarios propuestos por las tecnologías, el proceso de definir estas nuevas reglas puede ser también provechoso para la comunidad académica. En efecto, el proceso de construir un nuevo cuerpo regulatorio requiere de, al menos, tres elementos: que las personas conozcan el fenómeno que se pretende regular, tanto en su descripción como en sus aspectos valorativos; que esté claro cuáles son las opciones para regular ese fenómeno; y un consenso sobre la respuesta que las normas van a proporcionar frente a ese fenómeno y las consecuencias que se van a generar ante su incumplimiento. La concreción de esos tres elementos en la realidad es un proceso de por sí provechoso porque estos implican el compromiso de los miembros de la comunidad académica con el problema y su posible o posibles soluciones.

VI.2. Revalorización del pensamiento crítico

La recopilación de información, el levantamiento bibliográfico e, incluso, la síntesis de conocimientos existentes son tareas que pueden ser ejecutadas automatizadamente con la ayuda de tecnologías de IA y, en particular, las generativas. Esto significa que tales tareas deberían dejar de tener una incidencia alta en el proceso de evaluación. Pero hay un área en la que, por el momento, las aplicaciones de IAG no han sido capaces de igualarnos: el pensamiento crítico y reflexivo. Si una parte importante de las tareas que integran la actividad de los estudiantes pueden ser externalizadas, lo lógico sería concentrarse en aquellas que aún no pueden serlo. Esta es una de las externalidades positivas que plantean las tecnologías de IAG: ofrecen una buena razón para revalorizar el pensamiento crítico.

Pero para revalorizar el pensamiento crítico primero se debe tener un concepto sobre él. De acuerdo con la descripción de Paul (2005), el pensamiento crítico es aquel que comprende el análisis, la evaluación y la mejora del propio pensamiento, y su resultado es el pensamiento creativo (p. 28).

Orientar la docencia hacia el pensamiento crítico requiere, después de la definición, de un consenso sobre la forma en la que dicha orientación puede ser materializada y de las metodologías para lograrlo. Todas estas cuestiones deberían estar en el centro de la actividad académica en las universidades.

La adopción del pensamiento crítico como un estándar para la evaluación, por ejemplo, ayuda a mitigar los riesgos de la IAG. Si la docencia y la evaluación se quedan en los niveles de datos, repetición y memorización, tales actividades pueden sucumbir frente a las tecnologías de la IA.

VI.3. Cambios en los paradigmas de la docencia y la evaluación

La revalorización del pensamiento crítico como horizonte de la docencia produce como consecuencia que una revisión, también crítica, de los paradigmas de docencia y evaluación se torne necesaria. Esta medida de mitigación consiste en la generación de espacios de discusión académica en la comunidad universitaria sobre los beneficios y riesgos de la IA en la actividad docente. Este proceso de discusión tiene como externalidad la difusión de las problemáticas y pone a los miembros de la comunidad académica en la posición de tener que analizarlos y adoptar puntos de vista y convicciones sobre la cuestión. El proceso de discusión puede generar una simbiosis importante -y positiva- con la medida de adaptación normativa, ya que el mayor conocimiento de la norma asegura su mayor efecto expresivo-integrador.

A nivel operativo, la irrupción de la IAG obligará a repensar aspectos importantes de la docencia, como la evaluación31. La IAG puede ayudar enormemente en el proceso de evaluación, proveyendo a los profesores de instrumentos creativos capaces de estimular el interés y la imaginación de los estudiantes, pero sus riesgos obligan a adoptar medidas más concretas. Por lo pronto, un desafío para los profesores es el de ser capaces de generar «preguntas resistentes al fraude» (Susnjak, 2022, p. 4), como aquellas en las que el estudiante deba generar un conocimiento nuevo aplicando los contenidos estudiados. Mi área de especialización, el derecho penal, se presta particularmente para preguntas de desarrollo de casos, por ejemplo. Otras cuestiones, como la revalorización de las examinaciones presenciales, aparecen como buenas alternativas, así como diseñar instrumentos de evaluación que escapen de las posibilidades -actuales- de la tecnología: preguntas con enunciados largos, cuya resolución requiera aplicación o pensamiento crítico, de la habilidad de integrar conocimientos o que se refieran a información que quede fuera del periodo comprendido en la información de entrenamiento (Rudolph et al., 2023). En otras palabras, frente a la llegada de las tecnologías de IA, la evaluación -más que nunca antes- requiere apuntar a la recogida de evidencia sobre si los/las estudiantes fueron capaces de internalizar los conceptos marco del derecho, como el razonamiento jurídico o el Estado de derecho, y su integración con los conceptos centrales de cada disciplina, de acuerdo con la distinción entre ambos propuesta por Donson y O’Sallivan (2017, pp. 23-26).

VI.4. Cuestionamiento de modelos de e-learning

Los entornos de aprendizaje asincrónico, también conocidos como e-learning, ofrecen buenas oportunidades para una difusión de prácticas desleales y conductas disvaloradas con relación a la integridad académica, en especial la evaluación en tales entornos asincrónicos (Grijalva et al., 2006; Stuber-McEwen et al., 2009; Carabantes Alarcón, 2020; Holden et al., 2021; Chiang et al., 2022). La creciente popularidad de estos entornos de aprendizaje debería considerar la irrupción de las tecnologías de IAG; una valoración profunda de la compatibilidad de ambas es, en todo caso, recomendable, en particular en los procesos de evaluación. En estos entornos, la evaluación carece de los mecanismos de control formal que conllevan las aplicadas presencialmente. Uno de esos mecanismos -el más básico- es la vigilancia directa, que impide que los estudiantes externalicen el desarrollo de sus respuestas a aplicaciones de AIG. Si el entorno carece de esa vigilancia directa, el desarrollo de una evaluación puede ser externalizada a una IAG. La complejidad del tema impide analizarlo en profundidad aquí, por lo que me parece apropiado solo dejarlo planteado para futuras investigaciones sobre la materia.

VII. CONCLUSIONES

El vertiginoso desarrollo tecnológico que está registrando la IA tiene un enorme potencial para la docencia en las universidades. En el otro lado de la moneda, esas mismas tecnologías plantean desafíos sobre los que se requieren procesos continuos de investigación, discusión y análisis. En particular, las tecnologías algorítmicas de escritura y de generación de contenido (IAG) están obligando -queramos reconocerlo o no- a replantear los paradigmas con los que hemos impartido la docencia y, como parte de ella, aquellos con los que se ha evaluado el aprendizaje o la obtención de competencias por parte de los estudiantes.

Una buena demostración de las nuevas realidades que plantea la IA son las posibilidades que ofrece la aplicación ChatGPT. Usada deshonestamente, esta puede suplantar al estudiante en sus evaluaciones, principalmente las escritas por medio de ensayos, memorias de grado o tesis.

Este artículo ha tenido como objetivo la exposición sintética de las relaciones eventualmente problemáticas con la IA (y, dentro de ella, con la IAG). En ese sentido, actúa como un primer encuentro con la temática expuesta y, a su vez, representa el inicio de una línea de investigación sobre la materia, intentando un examen de la bibliografía existente. Su hipótesis, que ha tomado como punto de partida la definición de integridad académica como un conjunto de valores (ver Figura 1), plantea que las tecnologías de IAG amenazan directa o indirectamente tales valores y se configuran, en consecuencia, como riesgos para esta.

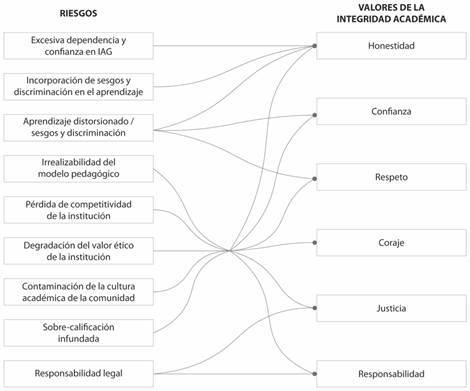

Como parte del análisis, se ha propuesto una taxonomía de riesgos, subclasificada en riesgos procedimentales y de resultado; y en su exposición se ha establecido la relación entre tales riesgos y los valores de la integridad académica. A modo de síntesis, dichas relaciones se grafican en la Figura 3.

Fuente: elaboración propia.

Figura 3 Relación entre los riesgos para la integridad académica y los valores que la componen

Finalmente, y sobre la base de la identificación de los riesgos y de sus relaciones conflictivas con los valores de la integridad académica, se propusieron cuatro medidas de mitigación. Estas son la adaptación de los marcos normativos de las universidades para que sus propias regulaciones den cuenta de las tecnologías de IAG y de su impacto sobre la actividad académica; la revalorización del pensamiento crítico como estrategia para relevar la importancia de la docencia y cómo esta debería enfocarse al desarrollo en los/las estudiantes de una actitud crítica y reflexiva, habilidades que, por el momento escapan a las posibilidades de la IAG; cambios en los paradigmas de docencia y evaluación, lo que supone reconocer la existencia de la IAG y cómo esta pueda alterar negativamente tales procesos; y el cuestionamiento de los modelos pedagógicos asincrónicos basados en tecnologías de información y comunicación.

La llegada de las tecnologías de IA y, en particular, de las de IAG, requiere que las universidades partan por conocerlas y comprenderlas. Este proceso permitirá tomar conciencia no solo de las ventajas y posibilidades que ellas entregan para la innovación pedagógica, sino también de los riesgos. La docencia, entendida como un proceso, podría verse profundamente alterada por la irrupción tecnológica. Como las universidades no tienen capacidad ni de detener el desarrollo tecnológico ni de impedir que sus estudiantes utilicen estas tecnologías emergentes, solo les queda actuar para aprovecharlas y regularlas. En todo caso, ellas ofrecen un buen escenario para iniciar o retomar un proceso de discusión sobre la integridad académica.