Servicios Personalizados

Revista

Articulo

Indicadores

-

Citado por SciELO

Citado por SciELO

Links relacionados

-

Similares en

SciELO

Similares en

SciELO

Compartir

Revista Peruana de Medicina Experimental y Salud Publica

versión impresa ISSN 1726-4634

Rev. perú. med. exp. salud publica vol.31 no.3 Lima jul./set. 2014

Simposio

Evaluación por competencias en la educación médica

Competency-based assessment in medical education

Denisse Champin1,a

1. Escuela de Medicina, Universidad Peruana de Ciencias Aplicadas, Lima, Perú.

a Médico internista, magíster en Docencia Universitaria, doctora en Administración y Dirección de Empresas

RESUMEN

En la actualidad, se considera al modelo curricular por competencias el más apropiado para la educación médica. Mucho se ha escrito sobre este modelo curricular, sin embargo, un aspecto crucial es la evaluación del desarrollo de las competencias, este es el punto diferente frente al modelo tradicional de evaluación eminentemente cognitivo. La evaluación en el contexto del modelo curricular por competencias debe estar alineada con el perfil de competencias que la institución propone. La presente publicación reporta la experiencia de evaluación en una escuela de Medicina del Perú que aplica un currículo basado en competencias

Palabras clave: Educación médica; Evaluación educacional; Escuelas de medicina (fuente: DeCS BIREME)

ABSTRACT

At present, competency-based curriculum is considered to be the most appropriate model in medical education. Much has been written about this model; however, a crucial aspect of the model is the assessment of competency development which is a different point compared to the traditional model of cognitive assessment. Assessment in the context of the competencybased curriculum model must be aligned with the profile of the competencies that the institution offers. This publication reports the evaluation experience in a Medical School of Peru that applies a competency-based curriculum.

Key words: Education, medical; Educational measurement; Schools, medical (source: MeSH).

INTRODUCCIÓN

Al ser la evaluación parte del currículo, resulta lógico deducir que si el modelo curricular se desplazó hacia uno basado en competencias, la evaluación deberá seguir la misma línea. A pesar que mucho se ha avanzado en el diseño curricular por competencias, el diseño de la evaluación no ha seguido el mismo esfuerzo, esta falta de alineamiento entre la educación por competencias y su evaluación compromete seriamente los resultados de este modelo (1).

El currículo es el camino que permite transformar a un lego en un profesional; el currículo cuenta con cuatro elementos: los contenidos, los logros, la metodología que se implementará y la evaluación (2). El presente artículo está orientado al último de dichos elementos.

EVALUACIÓN DEL APRENDIZAJE

La evaluación forma parte central del proceso educativo y cumple un papel relevante para los estudiantes, los docentes y la sociedad. En este sentido, los docentes ny stakeholders precisan conocer si el estudiante ha alcanzado el nivel apropiado para poder ser merecedor de una promoción hacia un nivel más alto de entrenamiento y también si al finalizar su formación el estudiante es competente para practicar como profesional (3).

Tradicionalmente, la evaluación ha sido utilizada para definir la promoción de un estudiante de un nivel a otro, sin embargo, existe otra manera de aplicar la evaluación, aprovechando su potencial como herramienta de aprendizaje, en este caso, la evaluación tiene fines formativos. La evaluación se puede aplicar a

un estudiante, a un equipo, a los materiales de estudio, al proceso educativo y a los logros planteados. Cuando se aplica a los alumnos, la evaluación es el proceso mediante el cual, los docentes generan información procedente de distintas fuentes con la finalidad de emitir un juicio de valor sobre el alumno (4).

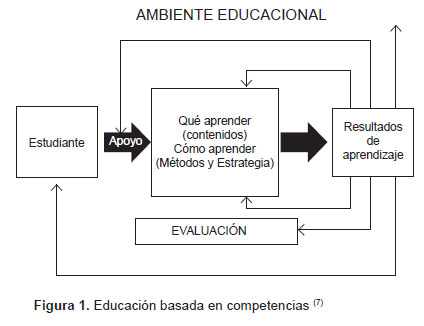

En el siglo XX se produjo un importante desarrollo de la psicología del aprendizaje y surgieron distintas corrientes educativas, siendo la educación por competencias un modelo sustentado en la corriente constructivista del aprendizaje. Esta corriente considera al estudiante como portador de conocimiento fruto de su interacción con el ambiente. Este conocimiento sirve de estructura base para la construcción de nuevo conocimiento a través de la implementación de un entorno educativo que reta al estudiante (5). En 1994 Spady describe un modelo curricular que partía por la definición de los resultados que se esperaba obtener como fruto de la aplicación del mismo y los tomaba como base para construir el currículo EBC (educación basada en competencias), este modelo es el prevalente en el mundo desarrollado en el presente siglo (6). En la Figura 1 se grafica el modelo basado en competencias (7), que muestra que los resultados de aprendizaje definen la metodología de la educación, sus contenidos así como la evaluación en un modelo curricular por competencias.

LA EVALUACIÓN POR COMPETENCIAS

La evaluación del estudiante es una tarea difícil para el docente, sin embargo, muchos docentes dedican mucho más tiempo y esfuerzo en la preparación de sus actividades de clase y reservan solo los últimos minutos para la evaluación. En este sentido, es importante remarcar que una buena evaluación precisa de tiempo para realizar una planificación de tal manera que sea justa, válida y esté alineada con los objetivos de aprendizaje (8). Cuando hablamos de alinear la evaluación con los objetivos del aprendizaje nos referimos a tener muy claro desde el inicio de la formación, cuál es el resultado que esperamos, dicho resultado (perfil de competencias de egreso) debe estar ampliamente descrito en forma de criterios tal como lo enuncia Tomorrow ´s Doctors (9) o en la forma de niveles como lo enuncia el Proyecto Tuning (10) y debe ser explicitado a los docentes, estudiantes y stakeholders desde la implementación curricular (11).

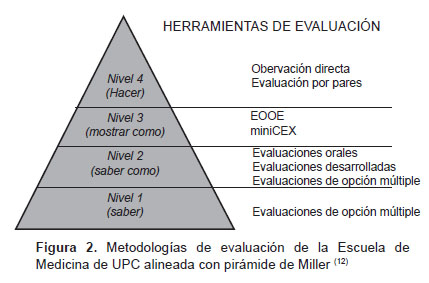

La evaluación de las competencias es una tarea compleja que requiere de un sistema que permita de manera holística valorar los conocimientos necesarios para el actuar de cualquier profesional, las destrezas o habilidades propias de la carrera y las actitudes que se enmarcan en el concepto del profesionalismo. La propuesta de evaluación descrita por Miller para el ámbito de la educación médica (12) y, en concreto, de la evaluación por competencias, desarrolla un modelo que permite valorar el nivel de adquisición de las competencias, siendo dicho modelo un referente en el tema de la evaluación. Su planteamiento no solo es válido para la formación médica, sino que se ha extendido a cualquier disciplina. La Figura 2 esquematiza el modelo.

A partir del reconocimiento que no existe ningún método que sea capaz de ofrecer todos los datos que se requieren para establecer el juicio sobre la competencia de un profesional médico, Miller propone una estructura piramidal, la cual acomoda en su base el primer nivel, relacionado con el saber. Este nivel constituye la base de conocimientos que un estudiante durante su formación debería adquirir. El segundo nivel de la pirámide lo constituye el saber cómo. A este nivel se espera que el estudiante desarrolle la habilidad de buscar información, analizarla e interpretarla, trasladando su conclusión a un plan diagnóstico o terapéutico para el paciente. El tercer nivel representa el mostrar cómo e implica un salto en la evaluación de la competencia clínica, puesto que en este nivel se contempla el comportamiento. Desde hace varias décadas este nivel de competencia se evalúa en ambientes simulados que cuentan con suficiente realismo (13). El cuarto nivel de la pirámide representa el hacer, es decir, la práctica cotidiana del profesional. Para valorarlo requiere del uso de herramientas de observación primordialmente, ya sean directas o a través de auditorías, videos u otros. Teniendo en cuenta los distintos niveles de la pirámide, está claro que se necesita combinar varios instrumentos para obtener juicios sobre el desarrollo de la competencia. Un aspecto crucial es la autenticidad, es decir, que las situaciones en las cuales sea evaluada la competencia sean lo más cercanas posibles a la realidad (14,15).

Tal vez la principal innovación en la evaluación de la formación de los futuros médicos se presenta en el diseño de las herramientas de evaluación de los dos niveles superiores de la pirámide. Estos niveles evalúan comportamientos y, por ello, el advenimiento hace más de treinta años de la simulación clínica brindó el espacio apropiado para evaluarlos. En esa línea, Barrows realiza una importante revisión acerca del uso de las herramientas de simulación clínica, específicamente en el uso de pacientes estandarizados (PE) para la enseñanza y la evaluación de las habilidades clínicas (16). Un PE significa el resultado del entrenamiento de una persona normal para representar una enfermedad al ser sometido a una historia clínica. El hecho de estar estandarizado asegura que los datos que brindará no variarán de estudiante en estudiante. El uso de los PE no remplaza a los pacientes reales pero permite transmitir confianza en los estudiantes al momento de aprender, lo cual es positivo en el momento de enfrentarse con pacientes reales.

Uno de los usos más extendidos de trabajar con PE es el examen clínico objetivo estructurado (ECOE), que permite evaluar el nivel tres de la pirámide de Miller. El ECOE es un formato de prueba en el cual se pueden combinar diferentes herramientas. Los candidatos deberán recorrer un circuito de estaciones dispuestas secuencialmente y en cada una de ellas deberá someterse a una evaluación de sus habilidades y actitudes (17). En muchas estaciones pueden utilizarse PE, simuladores de habilidades, escenarios complejos de simulación, interpretación de estudios laboratorio, lectura de imágenes, etc. Habitualmente, el número de estaciones está por encima de diez pudiendo llegar a las treinta. El tiempo por estación varía, pero algunas referencias (18) indican que normalmente se sitúa entre los cuatro y diez minutos, siendo el tiempo global de duración de la prueba de varias horas. Finalmente, el cuarto nivel de la pirámide está representado por el actuar en la práctica clínica. Para su evaluación se debe recurrir a herramientas como videos, observaciones directas, encuestas a enfermos y familiares de los pacientes atendidos.

LA EVALUACIÓN DE LAS COMPETENCIAS CLÍNICASLa evaluación en el campo clínico (workplace-based training) constituyen un eje fundamental en la educación médica en pregrado. El docente del campo clínico no sólo debe entrenar al estudiante sino que, a través de la implementación de un programa de evaluación formativo orientado a la observación de las actividades que el estudiante realiza y la retroalimentación sobre sus fortalezas y áreas de mejora, contribuye a la mejora continua de las competencias del estudiante, ello permite crear un vínculo entre el docente y el estudiante que se refuerza con el trabajo en equipo (19).

Con la finalidad de implementar la evaluación en el ámbito clínico se han creado una serie de herramientas que se vienen utilizando exitosamente en el mundo (20,21). Algunas herramientas como las de observación enfrentan al estudiante con un docente que lo observará mientras realiza el contacto clínico con un paciente. En Norteamérica este es el método más utilizado con alumnos de los dos últimos años de carrera. En este caso, los docentes anotan los resultados de la evaluación en un formato previamente diseñado siguiendo una escala de calificación. Un ejemplo de esta estrategia es el miniejercicio de evaluación clínica (miniCEX) (20). Si bien se aprecian diferencias según la institución, el concepto es el mismo: el de observar la actuación del estudiante y retroalimentar sobre aquellos puntos que la herramienta considera y que son conocidos tanto por el docente como por el estudiante. Se espera que cada estudiante sea sujeto de evaluación en varias oportunidades con distintos docentes y en distintas situaciones clínicas. El miniCEX cumple con tres requisitos básicos de una evaluación que facilita el aprendizaje:

1. Existe un alineamiento entre el contenido del programa de entrenamiento, las competencias que se esperan obtener como resultado educacional, y la estructura de la evaluación.

2. La retroalimentación del estudiante se realiza durante y/o después de la evaluación.

3. Los momentos de la evaluación están estratégicamente programados para dirigir el aprendizaje del estudiante a los resultados esperados.

Las evaluaciones que están basadas en la observación de las ejecuciones en el ambiente clínico precisan contar con evaluadores que sean expertos en observar y emitir juicios. De acuerdo con ello es preciso crear espacios de capacitación orientada a los evaluadores con la finalidad de desarrollar dichas capacidades (22).

LAS RÚBRICASAcompañar el aprendizaje de un estudiante requiere contar con un modelo que grafique los estadios por los cuales se atraviesa para desarrollar una determinada competencia. Esta tarea puede ser enfrentada gracias al uso de las rúbricas. Una rúbrica es un descriptor cualitativo que establece la naturaleza de un desempeño apoyándose sobre perspectivas de criterio. La rúbrica es una minuta, una pauta, una tabla que nos permite aunar criterios de evaluación, descriptores y niveles de logro (23). Tiene un carácter preestablecido y debe ser socializada con los estudiantes. Sirve para conocer cómo está aprendiendo el estudiante y, por ello, es considerada como formativa, incorporándose dentro del proceso del aprendizaje. Las rúbricas son importantes para los docentes porque ayudan a centrarse en los objetivos, facilitan el proceso de la evaluación y definen de manera específica el nivel de aprendizaje que se espera que alcancen los estudiantes. A su vez, son también importantes para los estudiantes porque les ayudan a ver lo que tienen que trabajar y entender la evaluación. Describir la metodología para construir una rúbrica escapa de la finalidad de este trabajo, sin embargo, referimos a los interesados al trabajo del profesor Gustavo Hawes (24).

EL SISTEMA DE EVALUACIÓN EN LA ESCUELA DE MEDICINA DE LA UPCEn la Escuela de Medicina de la Universidad Peruana de Ciencias Aplicadas (UPC) se ha desarrollado un sistema de evaluación que se aplica desde el primer ciclo de la carrera y que cubre los distintos niveles de la pirámide de Miller (Figura 2).

Probablemente, las innovaciones al modelo tradicional en las herramientas de evaluación corresponden a aquellas de los niveles superiores (3 y 4). En la UPC se sigue los lineamientos de la Universidad de Dundee (17) para el diseño de ECOE, en tanto que para la evaluación práctica clínica se ha realizado una modificación a la rúbrica propuesta por Norcini (20).

Después de aplicar el ECOE por seis años, destaca como beneficio de dicha herramienta de evaluación, la flexibilidad que brinda el examen, ya que en sus distintas estaciones se pueden evaluar aspectos procedimentales así como actitudinales. La implementación de esta herramienta precisa que los docentes la conozcan, y reconozcan el aporte que significa para el aprendizaje de los estudiantes. Es ideal poder contar con un centro de simulación con distintos ambientes como consultorios simulados, área de habilidades clínicas y ambientes de simulación compleja.

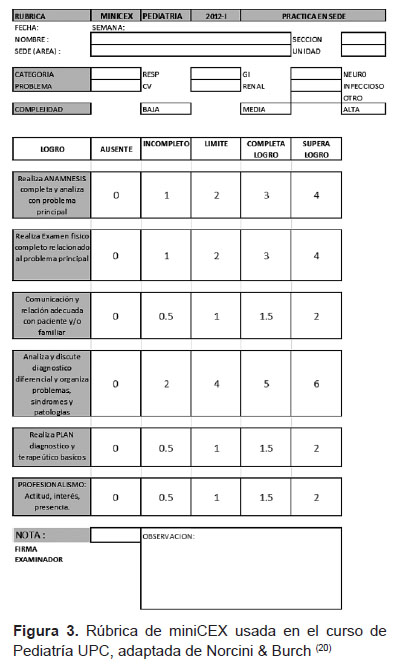

Con respecto a miniCEX, se viene aplicando desde hace 2,5 años y nuevamente se ha necesitado realizar una capacitación de docentes a fin de obtener los mejores resultados de la herramienta, en ella se pueden, al mismo tiempo, evaluar diferentes competencias del perfil profesional, en la Escuela de Medicina de la UPC todos los cursos de clínica lo aplican. Habitualmente, durante un ciclo de 14 semanas, se aplican cuatro evaluaciones de miniCEX a cada estudiante, en cada una de dichas evaluaciones un docente del curso, que no ha sido tutor del estudiante pero que conoce los logros esperados para cada ítem de la rúbrica, actúa como evaluador. La rúbrica se construye con la participación de los docentes del curso a partir del modelo de Norcini pero se adapta a nuestra realidad (20). En la Figura 4 se presenta el modelo de una rúbrica para miniCEX que se aplica desde el año 2012.

Un tema fundamental es que la rúbrica tiene un espacio de observaciones en la cual el docente y el estudiante acuerdan colocar las áreas de mejora y las acciones a tomar para efectivizarlo, así, esta herramienta se convierte en un compromiso entre docente y estudiante para la mejora.

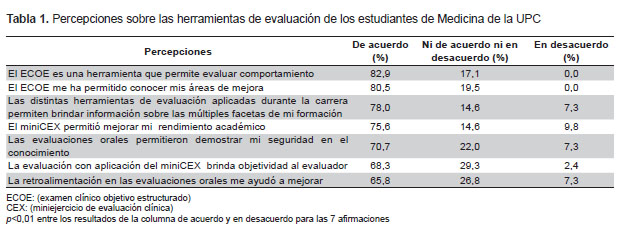

Un aspecto importante es conocer las percepciones de nuestros alumnos sobre las metodologías educativas que aplicamos con ellos (25). Por ello, en el año 2012 se aplicó un cuestionario a una muestra no probabilística de alumnos de los dos últimos años que incluía una escala de 7 ítems para medir las percepciones sobre los métodos de evaluación que habían recibido en la carrera (ECOE, miniCEX y evaluaciones orales) usando una escala de Likert (26). La escala fue construida luego de hacer entrevistas a docentes y evaluadas en un piloto con 22 estudiantes. Los resultados se muestran en la Tabla 1.

Aplicar un diseño por competencias para la educación médica obligó a investigar experiencias en otras latitudes para comprobar que dichas competencias se estaban desarrollando durante la formación (14,17,20). Se encontró que los niveles 1 y 2 de Miller, al ser cognitivos, se podían valorar apropiadamente con herramientas tradicionales como evaluaciones escritas (de elección múltiple o desarrollada) así como evaluaciones orales. La innovación, en este caso, se presentó al diseñar herramientas que permitieran valorar el nivel 3 de dicha pirámide. En este punto, se encontró una enorme ventaja en contar con un centro de simulación de alta fidelidad en el cual se pudo recrear múltiples estaciones para evaluaciones de todos los cursos de clínica médica así como de Pediatría, Ginecoobstetricia y Cirugía; en este ámbito, los estudiantes demostraron que sabían. (Nivel 3 Millar) Ya en el campo clínico, se orientó la evaluación con el uso de rúbricas como la del miniCEX (20) para hacer una observación supervisada de las habilidades clínicas. Estas dos herramientas nuevas significaron un aprendizaje tanto para los estudiantes como los docentes y les brindó a los egresados la seguridad y confianza al trabajar en pacientes reales.

Queda bastante claro, de la lectura de los resultados expuestos en la Tabla 1, que las actitudes de los estudiantes de las dos primeras promociones fueron favorables para el sistema de evaluación general de la institución así como para las tres herramientas investigadas (ECOE, miniCEX y evaluaciones orales) que se incluyeron en el cuestionario y que según la bibliografía y la información en el trabajo de campo son claves en la valoración de desarrollo de competencias.

CONCLUSIONESLa aplicación de un diseño basado por competencias necesita ir aparejado de una evaluación orientada a medir el desarrollo de dichas competencias. Consideramos que el primer paso para emprender con éxito esta tarea descansa en que el perfil de egreso del profesional se encuentre claramente definido incorporando todos los criterios que describen completamente cada una de las competencias. Este perfil así descrito se convierte en la estructura sobre la cual se diseñará la evaluación. El segundo factor clave incluye una plana docente que conozca plenamente las bases de la educación por competencia y que participe activamente en el diseño de las herramientas y en su correcta implementación.

En la UPC se ha implementado un sistema de evaluación que cubre los cuatro niveles de la pirámide de Miller, dicho sistema de evaluación ha permitido formar un profesional médico que es consciente de sus competencias, con una sólida formación científica que les ha permitido ubicarse entre las tres mejores escuelas de medicina del Perú (27) y que tiene un distintivo comportamiento en el campo clínico a juicio de sus tutores de internado y externado.

Fuentes de financiamiento: autofinanciado.Conflictos de interés: la autora es directora de la Escuela de Medicina de la Universidad Peruana de Ciencias Aplicadas.

Referencias Bibliográficas

1. Shumway JM, Harden RM; Association for Medical Education in Europe. AMEE Guide No. 25: The assessment of learning outcomes for the competent and reflective physician. Med Teach. 2003 Nov;25(6):569-84. [ Links ]

2. Prat-Corominas J, Oriol-Bosch A. Proceso de Bolonia (IV): currículo o plan de estudios. Educ Med. 2011;14(3):141-9. [ Links ]

3. Harden R, Laidlaw J. Essential skills for a medical teacher: An Introduction to Teaching and Learning in Medicine. London: Churchill Livingstone; 2012. [ Links ]

4. Gimeno Sacristán J, Pérez Gómez A. Comprender y Transformar la enseñanza . Madrid: Ediciones Morata; 1992. [ Links ]

5. Chadwick C. La psicología de aprendizaje del enfoque constructivista . Rev Latinoam Estud Educ. 2006;31(4):111-26. [ Links ]

6. Spady W. Outcome Based Education: Critical issues and answers. Arlington VA: American Association of School Administrators; 1994. [ Links ]

7. Harden RM. AMEE Guide N°14: Outcome-based education: Part 1An Introduction to outcome – based education . Med Teach. 1999;21(6):7-14. [ Links ]

8. Risco G. Los nuevos roles del docente y su aporte a la calidad de la educación médica . En: Colegio Médico del Perú. Cuadernos de Debate en Salud: Calidad de la educación en la formación médica. Lima: Colegio Médico del Perú; 2010. p.10-15. [ Links ]

9. General Medical Council. Tomorrow´s Doctors. Outcomes and standards for undergraduate medical education . London: General Medical Council; 2009. [ Links ]

10. Cummings A, Ross M. The Tuning Project (Medicine). Learning outcomesCompetences for undergraduate medical education in Europe . Edinburgh: Tuning Project (Medicine); 2008. [ Links ]

11. Harden R, Laidlaw J. Essential skills for a medical teacher. Elsevier: London; 2012. [ Links ]

12. Miller G. The assessment of clinical skills/ competence/ performance . Acad Med. 1990;65(9 Suppl):S63-7. [ Links ]

13. Nolla-Domenjó M. La evaluación en la educación médica. Principios básicos . Educ Med. 2009;12(4):223-9. [ Links ]

14. Durante E. Algunos métodos de evaluación de las competencias: escalando la pirámide de Miller . Rev Hosp Ital B Aires. 2006;26(2):55-61. [ Links ]

15. Epstein R. Assessment in medical education . NEJM. 2007;356(4):387-96. [ Links ]

16. Barrows H. An overview of the uses of standardized patients for teaching and evaluating clinical skills . Acad Med. 1993;68(6):443-51. [ Links ]

17. Davis MH. OSCE: the Dundee experience. Med Teach. 2003;25(3):255-61. [ Links ]

18. Martinez Carretero JM. Los métodos de evaluación de la competencia professional: la evaluación clínica objetivo estructurada (ECOE) . Educ Med. 2005;8(Supl 2):18-22. [ Links ]

19. Holmboe ES, Sherbino J, Long DM, Swing SR, Frank JR. The role of assessment in competency – based medical education. Med Teach. 2010;32(8):676-82. [ Links ]

20. Norcini J, Burch V. Workplace – based assessment as an educational tool: AMEE Guide N° 31 . Med Teach. 2007;29(9):855-71. [ Links ]

21. Burch VC, Seggie JL, Gary NE. Formative assessment promotes learning in undergraduate clinical clerkships. S Afr Med J. 2006;96(5):430-3. [ Links ]

22. Holmboe ES, Hawkins RE, Huot SJ. Effects of training in direct observation of medical residents´ clinical competence: A randomized trial. Ann Intern Med. 2004;140(11):874-81. [ Links ]

23. Capote A, Sosa A. Evaluación: rúbricas y listas de control [Internet]. 2006. [citado el 17 de junio del 2014]. Disponible en: http://www. josefinas-trinitarias.org/laasuncionc/ PJ/aplicaciones/adj/example/files/ Evaluacin.pdf [ Links ]

24. Hawes G. Evaluación: estándares y rúbricas. Talca: Universidad de Talca; 2004. [ Links ]

25. Bitrán M, Mena B, Riquelme A, Padilla O, Sanchez I, Moreno R. Desarrollo y validación de un instrumento en español para evaluar el desempeño de docentes clínicos a través de las percepciones de sus estudiantes . Rev Med Chile. 2010;138(6):685-93. [ Links ]

26. Huerta J. Procedimiento para redactar y validar los cuestionarios para los estudios de investigación y evaluación . Mayagüez: Universidad de Puerto Rico; 2005. [ Links ]

27. Asociación Peruana de Facultades de Medicina. Examen Nacional de Medicina (ENAM) [Internet]. Lima: Aspefam; 2014 [citado el 15 de enero del 2014]. Disponible en: http://www. aspefam.org.pe/enam [ Links ]

Correspondencia: Denisse Champin Dirección: Malecón Cisneros 1244 – 802 Miraflores. Lima, Perú Teléfono: (511) 313 3333 Correo electrónico: denisse.champin@gmail. com

Recibido: 21-07-14

Aprobado: 03-09-14