Introducción

Las universidades afrontaron múltiples desafíos para continuar impartiendo la enseñanza a dis- tancia después de la suspensión de clases presenciales a causa del Covid-19. Uno de los mayores retos ha sido la evaluación de aprendizajes en el contexto de la virtualidad. En Europa son las universidades, en primer lugar, las que toman medidas sobre la evaluación a distancia. Luego, otras instituciones también lo hacen y brindan orientaciones. En España, la Conferencia de Rectores de Universidades Españolas ofrece pautas sobre cómo llevarlas a cabo (Conferencia de Rectores de Universidades Españolas [CRUE], 2020). En el Reino Unido, la Agencia de Aseguramiento de la Calidad, en su documento titulado Assessing with Integrity in Digital Delivery, insta a que las universidades trabajen para evitar el engaño o falseamiento, el plagio u otros comportamientos impropios (Quality Assurance Agency for Higher Education [QAA], 2020).

En América Latina, la mayor parte de las universidades han implementado clases a distancia a través de plataformas virtuales. Se ha identificado como una debilidad por parte de los Rectores de Universidades líderes de Latinoamérica la carencia de instrumentos de evaluación o acreditación de saberes en la enseñanza virtual (Banco Interamericano de Desarrollo [BID], 2020).

En Uruguay, la declaración de emergencia sanitaria a causa de la detección de los primeros casos de Covid-19 hizo que la Universidad de la República (Udelar), la principal del país, suspendiera inmediatamente las clases presenciales y adoptara la modalidad a distancia. El rectorado impartió los lineamientos generales y mediante los órganos centrales de la universidad brindó apoyo y orientaciones técnicas. Se planteó inicialmente el tema de la evaluación para la certificación de los aprendizajes de los estudiantes, recomendándose un adecuado diseño y programación de las pruebas en la plataforma para reducir los problemas de copia (Universidad de la República/Comisión Sectorial de Enseñanza [Udelar/CSE] (2020a). Más adelante, en virtud de las inquietudes de los docentes sobre las herramientas y métodos de evaluación a distancia, se brindaron pautas concretas para cuidar la calidad de los instrumentos y los mecanismos de control que se pueden poner en práctica (Udelar/CSE, 2020b).

Por otro lado, antes de la pandemia, la Udelar estaba dando sus primeros pasos en la educación a distancia como una herramienta para afrontar las clases con matrícula numerosa, características de nuestra universidad que tiene libre ingreso, y también permitir la accesibilidad a la educación superior en todo el territorio nacional. Si bien diversas herramientas tecnológicas estaban siendo usadas para la enseñanza en forma virtual, no se había avanzado en la evaluación a distancia para la acreditación de saberes. El contexto de la pandemia acelera la implementación de la enseñanza a distancia y el mantenimiento de las medidas sanitarias obliga a utilizar evaluaciones a distancia en formato múltiple opción, especialmente en las facultades con mayor matrícula por cohorte (Udelar/ CSE, 2020b).

Por estos motivos, se aborda en este artículo los últimos avances teóricos y metodológicos para asegurar la validez de los resultados en las pruebas a distancia en forma síncrona.

A través de una revisión bibliográfica se indaga en el concepto de fraude o falseamiento, para luego centrarse en los métodos para detectar falseamiento en pruebas de opción múltiple.

En primer lugar, se presentan los antecedentes teóricos sobre la temática y el enfoque psicométrico por el que debe ser estudiado el fraude o falseamiento. En un segundo apartado se describirán los principales métodos que son utilizados para detectarlo, incluyendo los últimos desarrollos. Por último, se describirán los desafíos que, a juicio de los autores, enfrentan las instituciones de educación superior para la validación de los resultados de pruebas síncronas realizadas a distancia.

Antecedentes

En este apartado se referirán los conceptos de fraude o falseamiento, sus diversos tipos y por último, se planteará el problema de la validación de los resultados de las pruebas.

El fraude en una prueba o examen, o lo que comúnmente se denomina "copia", es un problema inherente a las evaluaciones. Ha sido ampliamente estudiado y, lamentablemente, se ha comprobado que el alcance de esta práctica ha tenido cierta magnitud de consideración (Whitley, 1998; Arthur, Glaze, Villado y Taylor, 2010).

Si bien el análisis de datos sobre fraude en pruebas comenzó en la década de los noventa del siglo pasado, ya hace casi cien años que se da cuenta del interés de detectarlo (Bird, 1927, 1929). Hacia fines del siglo XX, Whitley (1998) encontró, en una revisión de estudios, que el 43% de los estudiantes universitarios admitieron haber copiado en pruebas. En un estudio realizado en España, la mitad de los estudiantes encuestados declararon haber copiado al menos una vez durante un examen (Sureda, Comas & Gili, 2009). Un tercio de los actos de fraude encontrados por Friedman, Blau y Eshet-Alkalai (2016) fueron realizados utilizando tecnología. Si bien los estudiantes parecen ser más atraídos a cometer fraude en pruebas en línea sin monitoreo, los resultados no son tan alentadores para los que cometen fraude porque su desempeño correlaciona negativamente con los demás cursos en los que sus evaluaciones son monitoreadas (Arnold, 2016).

Técnicamente, denominaremos falseamiento a distintos tipos de fraude en pruebas. Cizek (2012) define al falseamiento como cualquier acción tomada antes, durante o después de la administración de una prueba o tarea, con la intención de tomar ventaja injusta o producir resultados incorrectos. La educación a distancia se ha enfocado en este tema, ya que, tanto docentes como estudiantes consideran que es mucho más sencillo el falseamiento en una prueba tomada a distancia que en una presencial en soporte papel (Arnold, 2016; Chirumamilla, Sindre & Nguyen-Duc, 2020). Algunos autores, como Brimble (2016) y Sutherland-Smith (2016) van más allá y sugieren que los entornos digitales parecen promover el fraude por las facilidades que ofrecen para obtener información, cortar y pegar o acceder a ayuda externa.

Tipos de Falseamiento

Se pueden distinguir diferentes tipos de falseamiento. Chirumamilla et al. (2020) sintetizan lo estudiado por la literatura en los últimos años y diferencian los siguientes tipos de falseamiento:

Sustitución: alguien más realiza la prueba.

Ayudas prohibidas: usar documentos o herramientas no permitidas durante la prueba.

Copia: copiar las respuestas de otros estudiantes. Puede darse con el consentimiento del estudiante al que se le copia o sin su consentimiento.

Cooperación entre estudiantes: los estudiantes cooperan entre sí para responder la prueba.

Asistencia externa: conseguir ayuda ilegítima (calificada) de alguien externo durante la prueba.

Colusión: ayuda ilegítima de un docente o funcionario u otro estudiante durante la prueba o para tener acceso previo a la prueba.

La mayoría de estos tipos de falseamiento se puede controlar o limitar mediante un sistema de monitoreo continuo de autenticación de la identidad. Sin embargo, la aplicación de pruebas síncronas en formato opción múltiple conlleva la necesidad de analizar si se ha producido algún tipo de falseamiento.

Entonces, surge la interrogante sobre cómo validar los resultados de las pruebas tomadas a distancia. El concepto de validez aparece como central, porque además de pruebas adecuadamente diseñadas, fiables, necesitamos que las puntuaciones obtenidas sean válidas (Abad, Olea, Ponsoda & García, 2011). Se parte del supuesto de que el docente planteó una evaluación que reúne las siguientes condiciones:

Es acorde a los propósitos y objetivos de aprendizaje.

Está correctamente diseñada.

Los ítems o tareas representan correctamente el constructo a evaluar (Rodríguez Morales, 2017).

Los ítems o tareas fueron construidos adecuadamente (Unidad de Apoyo a la Enseñanza [UAE], 2020).

Los ítems son condicionalmente independientes unos de otros y los distractores son apropiados, es decir, que se haya estudiado la calidad de los ítems (Rodríguez & Luzardo, 2014).

Estas condiciones proporcionan evidencias de la validez de la prueba. Sin embargo, es necesario poder brindar evidencias sobre la validez de los resultados de las evaluaciones a distancia.

Validación de los Aprendizajes a Distancia a través de Pruebas Síncronas

La necesidad del estudio de falseamiento como parte de las evidencias por recoger para la validez de la interpretación de los resultados es el enfoque que tomaremos en este artículo. Considerando como reprobables los efectos del fraude, el foco estará en las evidencias sobre la validez que aportan los estudios de falseamiento. Los Standards for Educational and Psychological Testing señalan que la validez es el aspecto que se debe considerar como fundamental en el desarrollo y evaluación de las pruebas (American Educational Research Association, American Psychological Association, and National Council on Measurement in Education [AERA, APA, & NCME], 2014). La validez refiere a la forma en que se interpretan las puntuaciones en las pruebas para determinar si el uso que se pretende es correcto o no. Las puntuaciones en las pruebas son consideradas válidas cuando las interpretaciones o inferencias basadas en esos puntajes son correctas o precisas (Cizek & Wollack, 2017). El falseamiento opera directamente sobre las puntuaciones de las pruebas, haciéndolas menos precisas, por eso es necesario que se analice y detecte esta situación. De esta forma, el estudio del falseamiento aporta a la validez de la interpretación de las puntuaciones.

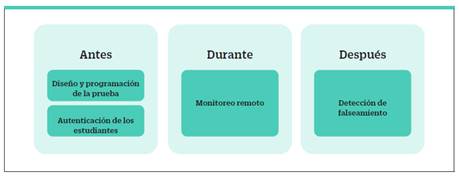

Se pueden identificar tres momentos en los que es necesario recoger evidencias sobre la validez de los resultados de la prueba, esto es, tareas para realizar antes de su aplicación, durante y después de ella (Rodríguez Morales, 2020), como se presentan en la figura 1.

Sindre y Vegendla (2015) demostraron que las pruebas a distancia no son menos válidas que las realizadas en papel y que la seguridad de las pruebas en línea depende de las medidas tomadas durante estos tres momentos.

En primer lugar, se debe considerar el diseño y programación de la prueba. Construir pruebas de opción múltiple no es sencillo, por eso es necesario tomar ciertas precauciones a la hora de diseñarlas. Recogemos las siguientes sugerencias:

Elaborar un banco de ítems amplio, cuidando de redactar la misma cantidad de ítems fáciles, medios y difíciles. Muñiz y Fonseca-Pedrero (2019) recomiendan que se elabore el doble de ítems de los necesarios.

Disponer en forma aleatoria los ítems del cuestionario. De esta forma se evita que los estudiantes identifiquen el ítem con una posición en la prueba.

Si se diseñan pruebas fijas, construir cuadernillos equivalentes en cuanto a la cobertura de contenidos, dificultad de los ítems, cantidad y tipo de ítems.

Establecer en forma aleatoria las opciones de respuesta dentro de cada ítem (Udelar/CSE, 2020b).

Evitar los ítems verdadero/falso porque aumenta la probabilidad de respuestas al azar.

Elegir entre tres y cinco opciones de respuestas para cada ítem. Abad, Olea y Ponsoda (2001) recomiendan los ítems de tres alternativas por ser menos susceptibles a la presencia de conocimiento parcial. Ortega Torres y Chávez Álvarez (2020) también proponen que tres opciones de respuesta es el número de alternativas óptimo, ya que solamente hay que construir dos distractores plausibles.

Evitar las opciones de respuestas incorrectas (distractores) que resulten demasiado obvias.

Establecer un tiempo razonable para la duración de la prueba en forma sincrónica para toda la cohorte. Como señalan Prieto y Delgado (1996) es necesario lograr un equilibrio entre un número de ítems que asegure una fiabilidad adecuada y la duración apropiada al nivel de estudios.

Establecer la retroalimentación diferida para que sea una vez finalizada la prueba y en forma sincrónica para todos los estudiantes (Udelar/CSE, 2020b).

Antes de la prueba también es necesario la autenticación de los estudiantes y su verificación en la plataforma utilizada para la evaluación.

Cuando se aplican pruebas síncronas a estudiantes que oscilan entre 150 y 2.500, como sucede en la Udelar, es necesario implementar sistemas de monitoreo. Las plataformas virtuales de aprendizaje poseen un sistema continuo de autenticación de los estudiantes. Proporcionan monitoreo constante a través de un conjunto de herramientas de software que utilizan técnicas biométricas de reconocimiento facial, autorizan la grabación o fotografía de los estudiantes mientras están realizando la prueba, el acceso a micrófonos para la grabación de audio ambiente y controlan la apertura de pestañas en la computadora del estudiante. Estos sistemas suelen ser invasivos y surgen controversias en cuanto a la privacidad. Los estudiantes pueden percibir invasión del espacio personal y sentirse vigilados (Noguera, Guerrero-Roldán & Rodríguez, 2017).

Se ha creado otro tipo de programas para el monitoreo de las pruebas a distancia. A través del proyecto TeSLA se ha desarrollado un sistema de verificación de la autenticación de los estudiantes y la autoría de sus trabajos. La verificación de la identidad se realiza con datos biométricos obtenidos a través de la plataforma virtual cuidando especialmente la privacidad de los estudiantes, las normas educativas, tecnológicas y éticas europeas. Se ha utilizado para evaluar pruebas de respuesta construida, e-portafolios y aprendizaje colaborativo revisado por pares (Baró-Solé et al., 2018). También resulta especialmente útil para pruebas de carácter formativo o continuo (Amigud, Arnedo-Moreno, Daradoumis & Guerrero-Roldán, 2017).

Sin embargo, en las universidades latinoamericanas estos sistemas de verificación de la identidad y monitoreo son menos comunes. En la Udelar no tenemos disponible la aplicación para el monitoreo en la plataforma del Entorno Virtual de Aprendizaje, por lo tanto, no se puede realizar la tarea de corroboración de la identidad de quien realiza la prueba y su monitoreo durante su ejecución. Por eso, tenemos que valernos especialmente de las técnicas de detección de falseamiento que se pueden utilizar después de la aplicación de pruebas de opción múltiple (Yates, Godbey & Fendler, 2017). Los análisis para detectar falseamiento cobran vital importancia en nuestro contexto. Para ello es necesario conocer los distintos métodos de detección de falseamiento, cuáles son sus características, potencialidades y limitaciones.

Métodos de Detección de Falseamiento En esta sección se realiza una revisión bibliográfica de los principales métodos de detección de falseamiento, señalando sus usos, potencialidades y limitaciones. Se toman en cuenta aquellos índices que se refieren a detección de falseamiento para ítems de opción múltiple. No se consideraron los que detectan falseamiento en ensayos o pruebas de respuesta construida, ya que nos concentramos en los que se aplican al tipo de prueba utilizada en nuestra universidad. Se revisaron tanto aquellas investigaciones donde se presentan y aplican nuevos métodos como las que comparan el desempeño de los existentes en distintos escenarios.

Todos estos métodos no pueden probar que ha tenido lugar un fraude, únicamente pueden asignar una probabilidad de que ese engaño haya ocurrido (Zopluoglu, 2017).

Algunos de los tipos de falseamiento han tenido un gran desarrollo de métodos para su detección. Así, la copia y la cooperación entre estudiantes ha sido abordada en los índices que buscan evidencias sobre copiado de respuestas, es decir, los índices de respuestas similares.

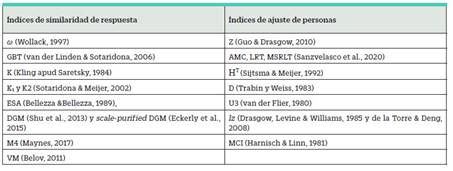

Se distinguen, principalmente, dos métodos para la detección de los distintos tipos de falseamiento: índices de similaridad de respuestas y los índices de ajuste de personas. Los primeros analizan el grado de acuerdo entre dos vectores de respuesta y los segundos examinan si un único vector de respuesta está alineado con cierto modelo de respuesta. Los índices de similaridad de respuesta pueden ser clasificados basándose en dos atributos: a) la distribución estadística de referencia y b) el grado de similitud entre las verosimilitudes de dos vectores de respuesta (Zopluoglu, 2017). También presentaremos, para finalizar este apartado, algunos enfoques más recientes con métodos alternativos.

Índices de Similaridad

Un primer grupo de índices de similaridad, que trabajan con el número de respuestas incorrectas idénticas, está constituido por los índices K (Saretsky, 1984), ESA (Bellezza & Bellezza, 1989), K1 y K2 (Sotaridona & Meijer, 2002), que utilizan la distribución binomial. En tanto, el S1 (Sotaridona & Meijer, 2003) está basado en la distribución de Poisson. Dentro del grupo de índices basados en la distribución empírica, el índice desarrollado más recientemente es el VM (Belov, 2011).

Un segundo grupo de índices trabaja sobre el número de respuestas idénticas correctas e incorrectas. En este grupo se destaca el S2 (Sotaridona & Meijer, 2003).

Un tercer grupo de índices toma todos los ítems. En este grupo se destaca el ω (Wollack, 1997), que ha sido ampliamente utilizado. Zopluoglu (2017) encontró que era el que presentaba mejor ajuste en respuestas similares.

Maynes (2017) estudia la potencial colusión individual con análisis de similaridad. Los tipos de falseamiento donde los examinados reciben ayuda de una fuente externa, se comunican o trabajan en conjunto para obtener las respuestas (cooperación) o donde existe colusión, pueden ser abordados con estadísticos de similaridad. Por lo tanto, suelen ser muy útiles para el estudio del falseamiento en las pruebas a distancia en formato electrónico, ya que los estudiantes pueden tener facilidades en el acceso a la comunicación con fuentes externas u otros estudiantes. El estadístico bivariado M4 (Maynes, 2017) es una opción reciente para la detección de este tipo de falseamiento.

Un abordaje del estudio de la colusión, en tanto preconocimiento de los ítems de la prueba, es presentado por Eckerly (2017), donde utiliza el Deterministic Gated Item Response Theory Model (DGM) (Shu, Leucht & Henson, 2013).

Índices de Ajuste de Personas

Los análisis psicométricos realizados mediante estadísticos de ajuste de personas son importantes para detectar patrones de respuesta aberrantes que producen puntuaciones inexactas en las pruebas. Los patrones de respuestas aberrantes incluyen el falseamiento, pero también otras conductas que llevan a mediciones poco precisas como las respuestas descuidadas, creativas o al azar.

Los índices de ajuste de personas se pueden clasificar en paramétricos y no paramétricos. Estos últimos no se basan en los parámetros estimados por la Teoría de Respuesta al Ítem, se calculan a partir del conjunto de datos de las puntuaciones obtenidas en una prueba. Los índices paramétricos miden la distancia entre el conjunto de datos de la prueba y las predicciones de respuestas estimadas derivadas del parámetro de estimaciones de un modelo de Teoría de Respuesta al Ítem.

Existen una gran cantidad de índices de ajuste de personas; sin embargo, hay pocas investigaciones sobre cuáles son más útiles. El último estudio comparativo fue el de Karabastos (2003) donde compara 36 índices de ajuste de persona (25 paramétricos y 11 no paramétricos), en diferentes condiciones, para obtener un mejor consenso en cuanto a sus desempeños.

Por otra parte, los índices de ajuste de personas presentan limitaciones para detectar copia, como demostró Zopluoglu (2017). Sin embargo, el HT (Sijtsma & Meijer, 1992), el D (Trabin & Weiss, 1983) son los mejores, como señaló Karabastos (2003).

Métodos Alternativos

Además de los índices de similaridad y de ajustes de personas, otros procedimientos pueden ser utilizados, según la información disponible de la prueba, como métodos competitivos o complementarios para la detección del falseamiento. Las pruebas a distancia en formato electrónico tipo opción múltiple permiten obtener información relevante como los tiempos de respuesta. Varios trabajos incorporan este parámetro a los modelos de Teoría de Respuesta al Ítem, por ejemplo, van der Linden et al. (2006 y 2010). Recientemente, este tipo de modelización ha sido utilizado como un camino alternativo para la detección de falseamiento (Qian, Staniewska, Reckase & Woo, 2016, Sinharay & Johnson, 2019 y Kasli Zopluoglu & Toton, 2020). Otra herramienta por considerar es partir del supuesto de que los estudiantes que falsean los resultados en las pruebas tengan un patrón de respuestas similar, por lo tanto, diversos métodos de clasificación automática pueden arrojar información acerca de estos grupos (Zopluoglu, 2019a y Man, Harring & Sinharay, 2019). Pueden ser implementados diferentes algoritmos, por ejemplo k-medias, SVM, bosques aleatorios, redes neuronales y pueden compararse sus resultados con los obtenidos a través de los índices clásicos (Zopluoglu, 2019b).

Algunos Desafíos Metodológicos

Los índices de similaridad y de ajuste de personas funcionan en determinadas condiciones y fueron desarrollados para algunos análisis específicos de pruebas. Es necesario realizar un estudio comparativo de todos los índices, incluyendo los más recientes y contrastar su desempeño en diferentes situaciones. Uno de los últimos estudios de comparación de índices fue realizado hace casi 20 años. Karabastos (2003) estudió 36 índices de ajuste de personas y encuentra que los índices HT de Sijstma & Meijer (1992) y el D de Trabin & Weiss (1983) tienen un desempeño aceptable. Dentro de los índices de similaridad se encuentra que el ω y el GBT que utilizan Teoría de Respuesta al Ítem, el índice K y su contraparte que no usa Teoría de respuesta al Ítem y el índice VM funcionan bien en términos de potencia y de tasas de error tipo I. En nuestro país son muy escasas las evaluaciones que utilizan Teoría de Respuesta al ítem para la calibración de los ítems. Dentro del ámbito universitario solamente se ha utilizado para las pruebas de evaluación diagnóstica desarrolladas en el Centro Universitario Regional del Este (Rodríguez Morales, 2017). Entonces, es deseable estudiar más profundamente aquellos que no requieren Teoría de Respuesta al Ítem. Doyoung, Woo y Dickinson (2017) encuentran que el estadístico U3, que no utiliza Teoría de Respuesta al Ítem, es muy fácil de calcular, es prometedor y su desempeño es similar a los índices paramétricos.

En la Tabla 1, se presenta una lista de los principales índices de similaridad de respuesta y de ajuste de personas, que presentan mejores ajustes en determinadas condiciones. Se seleccionaron los índices recomendados por Karabastos (2003), Haney y Clarke, 2007, de la Torre y Deng, 2008, Guo y Drasgow (2010), Belov (2011, 2015), Eckerly, Babcock, & Wollack, 2015, Doyoung et al. (2017), Maynes (2017), Wollack & Cizek (2017), Zopluoglu (2016, 2017, 2019a, 2019b) y Sanzvelasco, Luzardo, García y Abad, 2020), que se obtuvieron a través de estudios de simulación.

En cuanto a la metodología para aplicar estos índices, Below & Amstromg (2010) sugieren un análisis en dos etapas: primero, hacer un screening usando índice de ajuste de personas para identificar potenciales falseadores y luego aplicar índices de similaridad entre esos potenciales falseadores. Esta es una estrategia adecuada para las necesidades de detección en pruebas de aprendizaje en el contexto de nuestra universidad, pero se necesitan más evidencias de su alcance y potencia porque algunas de sus propiedades aún no han sido suficientemente estudiadas. También se deben explorar nuevos enfoques, como la modelización sobre los tiempos de respuesta para la detección de falseamiento, que proponen Qian et al. (2016) y Sinharay & Johnson (2019) o los métodos de clasificación automática presentados por Zopluoglu (2019b) y Man, Harring & Sinharay (2019).

Como explican Wollack y Cizek (2017) muchos de los enfoques desarrollados hasta el momento para detectar falseamiento identifican comportamientos inusuales, sin una comprensión sólida de la naturaleza de ese fraude y no se identifican claramente las propiedades de los métodos de detección. Es decir, estos enfoques presentan un gran riesgo porque pueden detectar falseamiento donde no ocurrió o atribuir a comportamientos atípicos inocuos alguna forma de fraude. Wollack y Fremer (2013) sugieren que la mejor forma para trascender estos enfoques riesgosos es estudiar estas metodologías a través de investigaciones que combinen estudios mediante simulaciones y aplicaciones a datos reales que ayuden a comprender mejor las propiedades de estos métodos para una diversa variedad de situaciones. Por eso, es necesario investigar sobre el falseamiento, comparando estos métodos, identificando sus propiedades, potencialidades y debilidades a través de simulaciones en primer lugar y, luego, realizar aplicaciones a datos extraídos de pruebas reales.

La detección del falseamiento es un tema que incluye aspectos de diseño de pruebas, análisis y calibración de ítems, aplicación e interpretación de índices. Algunos de estos temas no son accesibles a todos los docentes universitarios. Por este motivo, es necesario crear una aplicación que pueda, en forma sencilla, aportar esta información a los docentes o responsables de las evaluaciones, de manera que se puedan tomar decisiones en función del tipo de evidencia encontrada. Estas decisiones pueden ir desde la mejora en los diseños y validación de instrumentos hasta la observación de posibles conductas de falseamiento que lleven a aplicar evaluaciones complementarias o generar decisiones de políticas de centrales.

Discusión

Esta crisis sanitaria que transitamos ha planteado grandes desafíos en el ámbito educativo, especialmente en la evaluación de aprendizajes. El principal reto lo constituye cómo asegurar evaluaciones válidas y detectar falseamiento en las pruebas a distancia síncronas. Varios son los aspectos en que las universidades deberían avanzar para lograr estos objetivos. En primer lugar, se necesita establecer estándares para el diseño y aplicación de pruebas a distancia, de la misma forma en que se desarrollan para las pruebas presenciales (Rodríguez Morales, 2017). Acordar protocolos que guíen a los docentes en el diseño de instrumentos de evaluación válidos y fiables es un aspecto fundamental para la medición. Se deben cuidar todas las fases de su desarrollo, desde el marco, la definición de las variables, la construcción de ítems, la edición, el pilotaje y la aplicación de la prueba, como señalan Muñiz y Fonseca-Pedrero (2019). El trabajo en el diseño y validación de pruebas debe ser desarrollado a través de la creación de bancos de ítems, su análisis y calibración, y la equiparación de cuadernillos. Esto puede implicar una limitación, ya que requiere de un trabajo previo de características técnicas, que no todas las unidades académicas están en condiciones de afrontar.

A su vez, se deben instalar sistemas de monitoreo de pruebas a distancia a través de las plataformas virtuales de enseñanza o crear otras plataformas exclusivamente para la aplicación de pruebas. Las propiedades de los sistemas de autenticación y monitoreo basados en técnicas biométricas son descritas en Baró-Solé et al., (2018) y Noguera et al. (2017) para pruebas de respuesta construida. Hernández-Ortega, Daza, Morales, Fiérrez, Ortega-García (2019) también comprobaron este tipo de sistemas para distintos tipos de evaluaciones, incluidas las pruebas de opción múltiple. Una limitación del enfoque de este artículo es que solamente se abordan los índices de detección de falseamiento para este tipo de pruebas, no considerándose los índices para pruebas de respuesta construida o ensayos.

Asimismo, para aplicar los métodos de detección de falseamiento a las pruebas de opción múltiple con mayor facilidad sería muy útil desarrollar una aplicación en la web, donde dado un conjunto de datos de pruebas, proporcione información a los docentes acerca del análisis de los ítems, su calibración y distintas pruebas para la detección del falseamiento. La investigación en métodos de detección de falseamiento, con el objetivo de encontrar los que se desempeñan mejor en distintos contextos, es central para concretar estos aportes. En este sentido, es necesario realizar estudios comparativos del desempeño y bondades de los distintos índices presentados mediante estudios de simulación y con datos reales.

La evaluación a distancia en formato electrónico tal vez sea una opción que pueda ofrecerse en el futuro a los estudiantes para tomar sus pruebas, más allá del contexto de la emergencia sanitaria planteada por el Covid-19, como el correlato de una enseñanza que seguramente tomará formatos híbridos donde se combine la educación presencial con la a distancia. De esta manera se podrá combatir la masificación, democratizar el acceso de los más alejados geográficamente o comprometidos familiar o laboralmente, que son los postulados de nuestra universidad (Udelar, 2020). Además, se podrá promover los principios de flexibilidad, movilidad y accesibilidad a los que se alinean las universidades europeas (Noguera et al., 2017). No todos los estudiantes elegirán esta opción por creer que pueden encontrar ventajas, ya existen evidencias de que muchos estudiantes son conscientes de las dificultades que implica una evaluación a distancia y no la eligen, como encontró James (2016) en su investigación.

Por lo tanto, se necesita crear unidades académicas con capacidades técnicas para realizar estas actividades de evaluación e investigación y formar más recursos humanos que estén capacitados para realizar estas tareas.