Introducción

En la localidad de Wuhan (China) a finales del año 2019 hizo su aparición mundial el coronavirus SARS-COV2, causante de la sintomatología patológica categorizada como COVID-19, altamente contagiosa y para la cual el sistema inmunológico humano no estaba convenientemente preparado. La rápida propagación del coronavirus SARS-COV2 en todo el mundo derivó en el estallido de la pandemia mundial que ha afectado profundamente a todos los países del mundo a lo largo de los dos siguientes años. Esta pandemia, derivada por el coronavirus SARS-COV2, ha tenido enormes consecuencias sociales en todos los ámbitos y niveles (Hosseinzadeh et al., 2022 ; Szcześniak et al., 2021 ). Uno de los ámbitos más afectados ha sido el ámbito educativo, puesto que el estallido de la pandemia cerró de forma prolongada todos los centros educativos en todos los niveles escolares e impidió la modalidad de educación presencial durante dos cursos escolares en la mayoría de los países. Además, las consecuencias de la pandemia ocasionaron innumerables y variadas medidas que afectaron de manera profunda en el desarrollo normal del proceso educativo, sobre todo entre los más vulnerables (de Oliveira Araújo et al., 2020 ; Vlachos et al., 2021 ).

Pérez y Hernández (2020) señalan que, en el caso de España, una vez los centros educativos migraron su actividad al nuevo entorno online durante el confinamiento, el principal problema no fue la falta de equipamiento, sino la escasa formación en el uso de las herramientas tecnológicas, tanto de estudiantes como de profesores. Si bien las posibles carencias de equipamiento fueron debidamente resueltas por los centros y las administraciones, no lo fueron las deficiencias formativas y de competencia digital, contribuyendo a aumentar la desigualdad. En esta misma dirección apunta Alharthi (2020 ), quien señala que la mayoría de los que han recibido formación en un entorno virtual, incluso en niveles educativos superiores, consideran fundamental recibir previamente formación específica acerca de la tecnología a emplear en dicho entorno, lo cual no resultó posible durante el confinamiento (García-Martín y García-Martín, 2021 ; Sánchez-Cabrero et al., 2021b ). Hay quien incluso habla de un cambio de paradigma en la educación tras la pandemia, más allá de los cambios coyunturales experimentados, basado en la combinación de las Tecnologías de la Información y la Comunicación (TIC) y la neuroeducación (Espino-Díaz et al., 2021 ).

Entre otros estudios, Bączek et al. (2021) estudiaron los efectos del repentino cambio de entorno de aprendizaje (de presencial a online) motivado por los confinamientos. A partir de las respuestas de 804 estudiantes a su cuestionario, llegaron a la conclusión de que éstos perciben ambos entornos como igualmente válidos para facilitar su aprendizaje, y que el 73% considera el entorno virtual tan ameno como el presencial. Ampliando esta comparativa, respecto a la vinculación del cambio repentino del entorno de aprendizaje con la afectación emocional de los estudiantes, el reciente estudio de Sánchez-Cabrero et al. (2022) observaron cómo, a pesar del cambio tan drástico y las múltiples consecuencias psicológicas y sociales en la población, la inteligencia emocional de los estudiantes no se veía afectaba, lo que permitía mantener un funcionamiento educativo adecuado durante la pandemia sin alterar de manera visible el rendimientoi académico o la ansiedad ante los exámenes. No obstante, el análisis comparativo de los entornos de aprendizaje presencial y virtual ya había ha sido ampliamente tratado con anterioridad a la pandemia. Paechetr y Maier (2010) , tras analizar la información de 2196 estudiantes acerca de su experiencia y preferencias por la enseñanza presencial o virtual (online), destacan como ventajas de la enseñanza virtual la claridad y coherencia de los materiales didácticos, el aprendizaje autorregulado y la distribución de información, mientras que como aspectos positivos de la enseñanza presencial se señalan la comunicación y las relaciones interpersonales. En Alonso y Blázquez (2009) se analizan las funciones de los docentes en entornos presenciales y virtuales (online) a partir del estudio de cuatro aspectos (contenido teórico, contenido práctico, interacción con el estudiante, y diseño de las actividades), concluyendo que no se aprecian diferencias estadísticamente significativas que se expliquen por el entorno en el que se desempeña la actividad docente. Por su parte, Johnson et al. (2000) realizaron un estudio comparativo de una misma asignatura impartida en un entorno presencial y en uno online. Para ello se analizaron, entre otros, tres aspectos del proceso enseñanza-aprendizaje: los resultados del aprendizaje, la valoración del docente por parte de los alumnos y la interacción alumno-profesor. En este estudio se evidencia una percepción ligeramente más favorable del docente en el entorno presencial, que podría explicarse por una mayor proximidad emocional. Los resultados de aprendizaje resultaron ser muy similares en ambos entornos.

En lo que a la interacción alumno-profesor se refiere, los resultados indican una percepción más favorable en el entorno presencial. En esta misma línea, Paul y Jefferson (2019), tras analizar las calificaciones de 548 alumnos de una asignatura a lo largo de 8 años consecutivos, cursada en formato presencial (401) y online (147), concluyen que no se aprecian diferencias estadísticamente significativas en los resultados alcanzados por los estudiantes, conclusión coincidente por la presentada por Toyne et al. (2019) .

Poco antes del inicio la pandemia ocasionada por el coronavirus SARS-COV2, Bengtsson (2019) concluyó en su estudio que los exámenes no presenciales eran la mejor forma de evaluación para los niveles educativos más altos porque facilitan un aprendizaje constructivo, permiten la reflexión y el desarrollo de capacidades cognitivas superiores, y al mismo tiempo convierten la evaluación en un proceso de aprendizaje. Advierte el autor de que estos exámenes no son recomendables en niveles inferiores por el riesgo evidente de conductas no éticas de los estudiantes.

Myyry y Joutsenvirta (2015) estudiaron la realización de exámenes de ‘libro abierto’, como alternativa idónea para una evaluación sumativa y formativa, evitando la negativa influencia que puede ejercer el plagio. Concluyen que el tiempo empleado en la preparación es similar en ambos tipos de examen, pero que para la mitad de los estudiantes la realización y el aprendizaje en los exámenes abiertos supuso una inversión mucho mayor de tiempo.

En otro estudio previo a la pandemia, Gaytan (2005) estudió los elementos necesarios para que las técnicas de evaluación sean efectivas en un entorno online y señala la necesidad de que éstas contemplen aspectos tan diversos como los requisitos tecnológicos, el estilo de enseñanza, el enfoque pedagógico y los resultados del aprendizaje. Con posterioridad Gaytan y McEwen (2007) estudiaron las estrategias de evaluación online y las técnicas efectivas. Su trabajo se lleva a cabo a partir de dos cuestionarios enviados a 85 docentes y 1963 estudiantes estadounidenses que participaban en entornos online, del que obtuvieron 361 respuestas (29 profesores y 332 alumnos). El cuestionario remitido a los docentes versaba sobre su percepción acerca de si la calidad de la docencia se veía afectada al desempeñarse en un entorno online, y sobre la efectividad de las estrategias de evaluación en dicho entorno. El enviado a los estudiantes trataba de medir la percepción de éstos sobre la efectividad de Internet como entorno de aprendizaje, y sobre las estrategias de evaluación más efectivas. Tras el análisis de los resultados, los autores concluyen que las estrategias deben basarse en una amplia variedad de tareas a realizar con regularidad, a partir de las cuales el docente pueda aportar, de manera puntual, un feedback significativo para su aprendizaje. Establecen que las técnicas efectivas son los proyectos, los portafolios, las autoevaluaciones y co-evaluaciones, y las tareas semanales con feedback inmediato. Para Deeley (2018) la evaluación sumativa puede utilizarse para el aprendizaje, de la mano de la tecnología adecuada. Esta transformación de la evaluación ‘del aprendizaje’ en una evaluación ‘para el aprendizaje’ debe producirse en un entorno en el que docentes y estudiantes confíen y se sientan cómodos y cercanos, y requiere de flexibilidad y progresividad en su implementación.

Siempre que el contexto lo permita, la preferencia de los estudiantes sobre la evaluación online y presencial debe ser tenida en cuenta (Hewson, 2012) .

Asimismo, Hewson (2012) estudia si esta preferencia condiciona los resultados obtenidos. Para ello, analiza dos cohortes consecutivas de 33 y 41 estudiantes, respectivamente, que cursaron la misma asignatura con los mismos docentes. Todos los estudiantes realizaron el mismo examen, pero los de la primera cohorte lo hicieron presencialmente y los de la segunda cohorte lo hicieron online. En su trabajo concluye que la preferencia no influye en los resultados, pero que ello no significa poder obviar la reticencia hacia las pruebas online, especialmente importante en los estudiantes de ciencias sociales y humanidades. En tiempos de pandemia del coronavirus SARS-COV2 cabría esperar un cambio en estas preferencias, con una mejor predisposición hacia la evaluación online, dado que las prioridades y preocupaciones de los estudiantes se sitúan en dimensiones no consideradas en el citado trabajo, como es la seguridad individual.

Autores como Fuller et al. (2020) Y Sánchez-Cabrero et al. (2021a) plantean el contexto actual como la oportunidad definitiva para ampliar y mejorar la forma en la que tradicionalmente se viene realizando la evaluación. El reciente estudio de Sánchez-Cabrero et al. (2021a) mostró cómo "la evaluación en línea supervisada brinda las mismas garantías de justicia e igualdad que los exámenes presenciales, incluyendo además las propias ventajas de la no presencialidad, que respaldan que se siga usando en el futuro, especialmente en títulos con muchos estudiantes que pueden provenir de muchas ubicaciones diferentes" (p. 1). No obstante, los autores también apreciaron cómo el medio de evaluación (online/presencial) generaba diferencias en el diseño de los exámenes por parte de los profesores, lo que repercutía en la dificultad de la prueba. En su estudio observaron que la inexperiencia de los profesores en el diseño de exámenes online hizo que diseñaran exámenes más fáciles, lo que hizo mejorar las calificaciones, aunque la distribución de puntuaciones según nivel se mantuvo inalterable, lo que permite concluir que no hay diferencias reales en el medio de evaluación, pero que los miedos o expectativas de los profesores sí que pueden afectar a los resultados, puesto que pueden incluir medidas compensatorias que pueden alterarlos (Sánchez-Cabrero et al., 2021a ).

Por todo lo expuesto, y debido a la oportunidad única que ha supuesto la lamentable situación de pandemia mundial, este estudio se plantea evaluar el impacto del cambio de entorno de aprendizaje implementado en una asignatura de grado en el ámbito universitario de Singapur a lo largo del año 2020, como consecuencia de las restricciones a la movilidad y al contacto social impuestas durante la pandemia ocasionada por el coronavirus SARS-COV2. La investigación se diseña con dos objetivos de investigación. En primer lugar, (1) se pretende comparar el rendimiento académico de la última cohorte con entorno de aprendizaje totalmente presencial con la primera cohorte con entorno de aprendizaje totalmente online, teniendo en cuenta, no solo la evaluación final global, sino también los distintos componentes evaluativos que la componen. En segundo lugar, (2) se pretende evaluar si el cambio de entorno de aprendizaje ha variado la valoración del profesor y la interacción docente-alumno, y si estos factores han influido en el rendimiento académico.

Basándonos en la literatura previa sobre este ámbito de estudio, expuesta previamente, podemos afirmar que el cambio repentino y las carencias formativas de los docentes podrían afectar negativamente, tanto al rendimiento académico como a la relación docente-alumno (Alharti, 2020 ; de Oliveira Araújo et al., 2020 ; Pérez y Hernández, 2020 ). No obstante, otro tipo de estudios destacan la capacidad de adaptación y resiliencia de los estudiantes a los cambios educativos, por lo que podemos hipotetizar que esas características de los alumnos modularán y reducirán los efectos adversos y el grado de afectación del cambio del entorno educativo, por lo que seguramente el grado de afectación sea escaso, o incluso imperceptible (Bączek et al., 2021 ; Sánchez-Cabrero et al., 2021a ; Sánchez-Cabrero et al., 2022 ).

Método

Diseño

El estudio propuesto se trata de un diseño ex post facto con carácter descriptivo, dado que parte de datos relativos a distintas calificaciones de los estudiantes y de sus encuestas de valoración. Es correlacional, pues analiza la correlación entre variables, como las calificaciones, y secuencial transversal, dado estudia dos cohortes consecutivas de una materia.

Participantes

En este estudio se pretendió utilizar una muestra representativa de la población universitaria de Singapur, pero realizando el estudio bajo el prisma de la estructura educativa occidental, así que, mediante muestreo por conglomerados, se seleccionó los estudiantes que cursaron la titulación oficial Bachelor of Business Studies programme de la prestigiosa University College Dublin en su vertiente internacional, con las dos cohortes más cercanas respecto al estallido de la Pandemia derivada del coronavirus SARS-COV2. La University College Dublin es una de las pocas universidades de todo el mundo que posee la acreditación ‘Triple Corona’ de EQUIS (Europa), AACSB (Estados Unidos) y AMBA (Reino Unido), lo que garantiza su perfil internacional, una gran excelencia educativa, transparencia y calidad en sus procesos educativos y en la fiabilidad y validez de sus procesos de evaluación. La muestra, estuvo compuesta por 282 estudiantes universitarios de grado, distribuidos en dos cohortes de 125 y 157 alumnos, con un rango de edad de entre 18 y 21 años. Todos los participantes se matricularon en el mismo módulo en ambas cohortes y completaron la nota y el formulario de evaluación estándar de la universidad, que garantizaba el anonimato de sus datos, la protección de sus derechos y su consentimiento informado al uso anónimo de sus resultados académicos y evaluaciones educativas con ánimo exclusivamente científico. Ambas cohortes presentan una muy elevada diversidad cultural, y en ningún caso se aprecian diferencias estadísticamente significativas en función del género. Se desconoce la distribución concreta de los participantes según sexo y edad por restricciones de protección a la intimidad impuestas por la universidad para garantizar el anonimato de los estudiantes. No obstante, la distribución equitativa y aleatoria según género y el limitado rango de edad evaluado (18-21 años) garantizan que ambas variables son variables controladas que no interfirieron en los resultados.

El sistema educativo en el que se enmarcan las enseñanzas objeto del análisis es el de Singapur, si bien la titulación también pertenece al Espacio Europeo de Educación Superior (EEES), que exige para su validación altos requisitos de fiabilidad y validez en todos sus procesos, lo que incluye un exquisito y escrupuloso uso de las encuestas de satisfacción de los alumnos con sus docentes y estudios (EURYDICE, 2020 ). El grado (180 ECTS) pertenece a la rama ciencias sociales, y se estructura por semestres, siendo posible comenzar los estudios en dos momentos diferentes del año, lo que se traduce en estos casos en la existencia de dos cohortes en cada año natural.

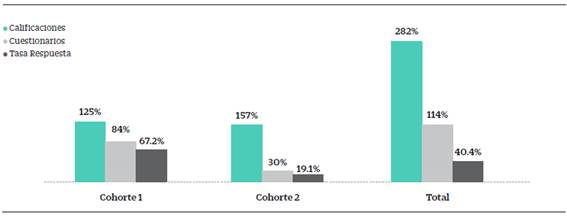

Para la primera cohorte (125 estudiantes) el entorno fue presencial, mientras que para la segunda (157 estudiantes) fue virtual, reemplazándose las clases presenciales por clases online síncronas. Tal y cómo se observa en la Figura 1, se dispone de las calificaciones finales y de sus componentes de evaluación continua de los 282 estudiantes, mientras que para el análisis valorativo del docente y de la interacción docente-alumno se dispone de los resultados de 114 cuestionarios, dado que rellenar dichos cuestionarios de evaluación era estrictamente anónimo y voluntario, como parte de su acuerdo con la universidad en el consentimiento informado del uso científico de sus valoraciones. La investigación se realizó al comienzo del cierre en Singapur, y los estudiantes se mostraron bastante entusiasmados y solidarios con el nuevo entorno de aprendizaje. Es posible que, si el estudio hubiera sido realizado en una época posterior, después de un mayor tiempo de confinamiento, el ánimo de los estudiantes ante la nueva metodología hubiera cambiado, pudiendo alterar los resultados obtenidos.

Instrumentos de obtención de datos y variables evaluadas

Las principales variables evaluadas en este estudio se describen a continuación:

a) Entorno de aprendizaje: Se trata de la variable principal del estudio. Variable nominal con dos niveles: entorno de aprendizaje presencial y entorno de aprendizaje online. Está formado por dos cohortes de una misma asignatura, cursada en el mismo año académico.

b) Rendimiento académico: Variable cuantitativa continua formaba por las calificaciones de los alumnos en cada uno de los componentes evaluativos: Proyecto de la asignatura, Examen final y Calificación global.

c) Valoración del profesor: Analizada a partir de las encuestas oficiales respondidas por los alumnos a través de nueve ítems en una escala Likert de cinco niveles.

d) Interacción alumno-profesor: Analizada a partir de las encuestas oficiales respondidas por los alumnos a través de tres ítems en una escala Likert de cinco niveles.

Los instrumentos de evaluación son dos. Por un lado, para el estudio del rendimiento académico se dispone de las calificaciones finales de los estudiantes, así como de las calificaciones de los componentes de dicha calificación final (un proyecto y un examen final escrito online). La confiabilidad de la evaluación del rendimiento académico de los alumnos ha sido medida a través del coeficiente Alfa de Cronbach, dando como resultado una confiabilidad adecuada (α= 0.786). Por otro lado, la valoración del profesor y la interacción alumno-profesor se analiza en base a los resultados obtenidos en las evaluaciones oficiales efectuadas por los estudiantes en una escala Likert de cinco niveles. Dichas valoraciones de los alumnos fueron gestionadas por una empresa externa, Kaplan Higher Education (Kaplan Higher Education, 2022 ), en virtud de las exigencias establecidas por el EEES (EURYDICE, 2020 ), garantizando su anonimato y protección de sus datos desde un proceso estrictamente neutro, previamente validado y gestionado externamente, certificando el cumplimiento de todos los requisitos éticos relativos al tratamiento de los datos. Lamentablemente, dicha evaluación externa reporta solamente el resultado final, por lo que no permite cálculo alguno de su confiabilidad de forma externa, aunque cumple con todas las garantías de validez y fiabilidad establecidas por el EEES (EURYDICE, 2020 ).

Procedimientos

Los datos se recopilaron del formulario de evaluación estándar diseñado previamente por la universidad, por lo que los estudiantes no sabían que eran parte de ninguna investigación específica, por lo que no se esperaban efectos Hawthorne, ni deseabilidad social relativa a respuestas específicas. En todo momento se siguió el protocolo estandarizado de la universidad, tanto para la evaluación mediante examen como en las encuestas de satisfacción de los estudiantes. Dicho proceso exige una evaluación de la interacción alumno-profesor por parte de los alumnos previa a su evaluación de aprendizaje, para que no sea un factor que influya en dicha evaluación (EURYDICE, 2020 ). Este sistema estandarizado cumple con todas las garantías establecidas por el EEES y por la autoridad competente de Singapur en materia de educación universitaria para garantizar objetividad y respetar todos los derechos y anonimato de los alumnos.

Análisis de datos

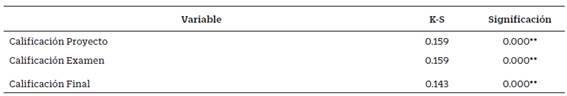

Para valorar la utilización de las pruebas estadísticas inferenciales adecuadas, previamente se realiza la Prueba de Kolmogorov-Smirnov (K-S), destinada a verificar si los datos de análisis siguen una distribución normal. Los resultados de la prueba K-S se muestran en la Tabla 1 a continuación.

Tabla 1 Resultados de la Prueba Kolmogorov-Smirnov

**Correlación significativa superior al nivel de confianza del 99%

Se puede observar en la Tabla 1 como ninguna de las distribuciones de los datos se corresponde a una distribución normal, por lo que es recomendable el uso de pruebas no paramétricas. Por lo tanto, para el estudio de las calificaciones obtenidas por los estudiantes se efectuará mediante un análisis correlacional de su distribución en ambas cohortes, utilizando la Rho de Spearman como estadístico de contraste, al ser un estadístico no paramétrico que permite la combinación de variables ordinales inclusive, y se realizará un tratamiento estadístico inferencial mediante la Prueba t para muestras independientes y la Prueba U de Mann-Whitney para muestras independientes como prueba no paramétrica.

Se establece un nivel de confianza superior al 95% (α=0.05) o al 99% (α=0.01) para aceptar la significación estadística de los resultados de los contrastes inferenciales o correlacionales que se realicen y se calcula el tamaño del efecto de los resultados inferenciales mediante ETA al cuadrado.

Los datos relativos a ambas cohortes y a todas las calificaciones se analizaron estadísticamente usando el Software estadístico IBM SPSS, versión 24. Igualmente, se compararán los resultados obtenidos en las encuestas de valoración del profesor efectuadas por los estudiantes de las dos cohortes. Para analizar la interacción alumno-profesor se revisarán las valoraciones de los estudiantes acerca de tres aspectos del nuevo entorno online, recogidos en el cuestionario respondido por los estudiantes de la segunda cohorte.

Resultados

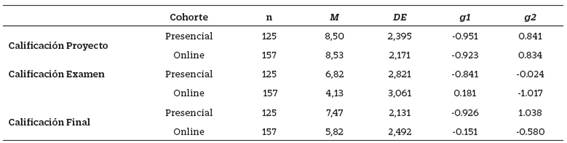

Respecto a la evaluación comparada del rendimiento académico, la Tabla 2 muestra el análisis descriptivo resultante en ambas cohortes según los estadísticos descriptivos: Media Aritmética y Desviación Típica y mediante los parámetros de distribución muestral asimetría y curtosis. Los estudiantes de la cohorte presencial (N=125) cursaron la asignatura en un entorno presencial durante el primer semestre, y los de la cohorte online (N=157) lo hicieron en un entorno online a lo largo del segundo semestre del año. El sistema de calificación es alfabético, estableciéndose el aprobado mínimo en D- y la calificación más alta en A+. Para su definición numérica se convierten las puntuaciones en una escala 0-12 (de 0= suspenso a 12= A+). La calificación final se obtiene a partir de las calificaciones de un proyecto (con una ponderación del 40%) y de un examen final escrito (con una ponderación del 60%). En la Tabla 2, puede observarse con claridad cómo existen diferencias notables entre ambos grupos en la Calificación Examen y en Calificación Final, siendo las diferencias en la Calificación Proyecto mucho menores. El análisis visual de los resultados, que se realiza a continuación en la Figura 2, puede ayudar a clarificar dichas diferencias.

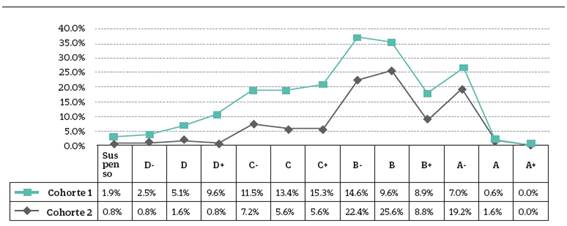

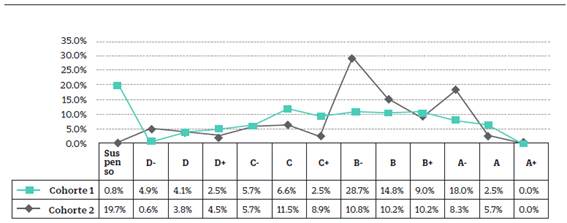

En la Figura 2, se puede ver que el porcentaje de suspensos en ambos casos es similar (inferior al 2%), pero la distribución de las calificaciones de los estudiantes que superaron la asignatura muestra una mayor concentración de calificaciones bajas (entre D- y C+) en la cohorte 2 online (57%) y de calificaciones altas (entre B- y A-) en la Cohorte 1 presencial (77%). La distribución de calificaciones de la cohorte 2 es muy similar a la distribución de calificaciones del conjunto de asignaturas del departamento, presentando una distribución más normalizada que la cohorte 1 presencial.

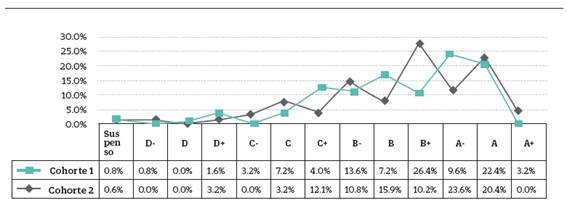

En las Figuras 3 y 4 se reflejan las distribuciones de calificaciones de ambos componentes que conforman la evaluación final.

Como se puede observar gráficamente en la Figura 3, la distribución de las calificaciones de los proyectos es muy similar para ambas cohortes.

En el caso de las distribuciones de las calificaciones del examen final, las diferencias entre ambas cohortes son relevantes. En la cohorte 2 online el porcentaje de suspensos es muy superior, mientras que en la cohorte 1 presencial hay más calificaciones altas (entre B- y A-). El análisis visual de los resultados parece indicar que la diferencia entre ambas cohortes podría deberse a las diferencias en la distribución de calificaciones del examen Final, tal y como puede verse en la Figura 4, por lo que se torna pertinente un análisis estadístico inferencial de los datos para determinar la significación de las diferencias entre ambos grupos.

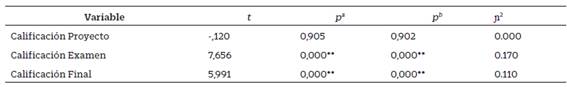

En primer lugar, para valorar la significación de las diferencias entre ambas cohortes se utiliza la Prueba t para muestras independientes, usando la t de Student como estadístico de contraste y la Prueba U de Mann-Whitney como prueba no paramétrica, también se calcula ETA al cuadrado para mostrar el tamaño del efecto de cada contraste. Los resultados obtenidos pueden observarse en la Tabla 3.

Tabla 3 Resultados de la Prueba t de Student y de la Prueba U de Mann-Whitney para muestras independientes

Nota. pa: significancia estadística de la prueba t Student; pb: significancia estadística de la U Mann Whitney; n2: Eta al cuadrado

Se puede observar en la Tabla 3 como, tanto la Calificación Examen como la Calificación Final, muestran diferencias estadísticamente significas según cohortes en los resultados, mientras que la Calificación Proyecto no muestra diferencias estadísticamente significativas. Teniendo en cuenta que la Calificación Final depende de ambas calificaciones, es posible afirmar que es la Calificación Examen la que genera las diferencias entre ambos grupos. Por lo que respecta al tamaño del efecto, el tamaño del efecto de la Calificación Examen, aunque baja, es considerablemente mayor que en las otras dos mediciones, lo que apoya la explicación de que es en el examen donde se observan las diferencias estadísticamente significativas entre ambas cohortes.

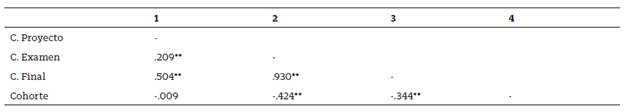

Finalmente, se analizan las correlaciones entre las distintas calificaciones para observar el grado de covariación existente entre calificaciones, utilizando la Rho de Spearman como estadístico de contraste, ya que permite incluir variables de tipo ordinal y se trata de un estadístico no paramétrico; así puede incluirse en la comparación también la variable cohorte convertida en escala ordinal, tal y como puede verse en la Tabla 4.

Tabla 4 Correlaciones entre las variables de estudio

Nota. ** rs Correlación significativa superior al nivel de confianza del 99% (bilateral).

El análisis de las correlaciones de la Tabla 4 reflejan que todas son estadísticamente significativas, lo que refleja una alta coherencia intrasujeto (es decir, las calificaciones dependen enormemente del esfuerzo y talento del alumno, lo cual es deseable). No obstante, es posible observar, al igual que en las comparaciones de medias, como la mayor asociación se produce entre la Calificación Final y la Calificación Examen y cómo la única correlación no significativa se da entre la Cohorte y la Calificación Proyecto.

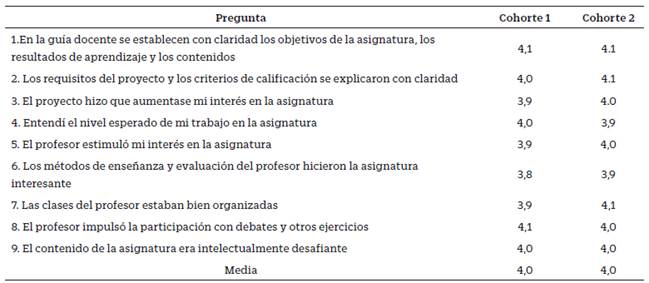

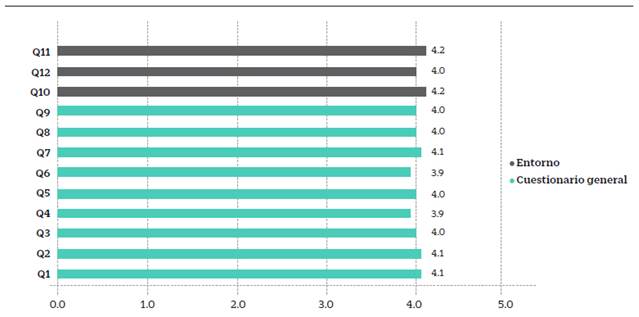

Por lo que respecta a la encuesta de valoración del profesor, ésta fue respondida por 84 de los 125 estudiantes de la cohorte 1 presencial, y por 30 de los 157 estudiantes de la cohorte 2 online. En la Tabla 5 se muestra el valor medio de las respuestas en una escala Likert de cinco niveles de cada cohorte según los nueve ítems planteados:

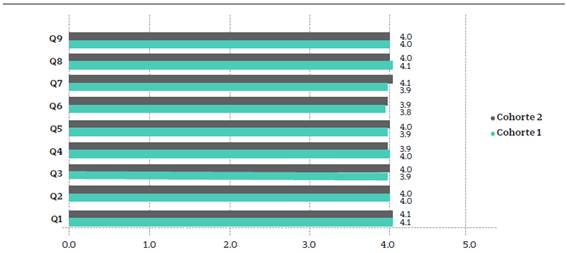

En la Tabla 5 se observa cómo existen muy pocas diferencias entre cohortes en la valoración de los profesores, por lo que se puede afirmar que el cambio de entorno de aprendizaje no fue un factor que alterara esta variable y las diferencias en los resultados académicos entre cohortes seguramente no sean debidas a una labor del profesor diferente. A continuación, la Figura 5 muestra visualmente estos resultados para ampliar la información sobre la que establecer conclusiones:

Al igual que ocurre con la Tabla 5, la Figura 5 muestra una alta consistencia en las valoraciones del profesor por parte del alumno, por lo que se refuerza la impresión de que las diferencias entre cohortes no estriban en la labor diferente del profesor. Lamentablemente, al ser una evaluación externa a este estudio, no es posible determinar la significación de las diferencias mediante estadística inferencial, lo cual hubiera servido para determinar la significación estadística de estas impresiones.

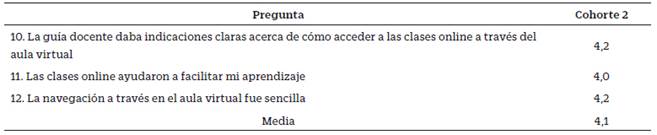

En el caso de la interacción alumno-profesor, se utiliza nuevamente la información de las encuestas de valoración del profesor realizadas por los estudiantes con metodología online, en las cuales, en relación con las encuestas de valoración de los estudiantes con metodología presencial, hay tres preguntas adicionales relativas al entorno. La encuesta fue respondida por 30 de los 157 estudiantes de la cohorte 2 online. La Tabla 6 muestra el valor medio de las respuestas según la escala Likert de cinco niveles en estos tres ítems:

Es observable en la Tabla 6 cómo las calificaciones obtenidas en las encuestas al alumnado sobre la interacción alumno-profesor en el entorno online reflejan que las diferencias en rendimiento académico entre ambas cohortes no residen tampoco en esta cuestión, puesto que las valoraciones son igualmente positivas a las valoraciones sobre el profesor, e incluso ligeramente mejores, por lo que también se puede afirmar que el cambio de entorno de aprendizaje no fue un factor que alterara esta variable. A continuación, la Figura 6 muestra visualmente estos resultados, integrando los resultados de las tres preguntas relativas al entorno con las nueve preguntas del cuestionario general para ampliar la información sobre la que establecer conclusiones:

La Figura 6 muestra una alta consistencia en las valoraciones sobre la interacción alumno-profesor en el entorno online por parte del alumnado, por lo que se refuerza la impresión de que las diferencias entre cohortes no estriban en una diferente interacción alumno-profesor. Lamentablemente, al ser una evaluación externa a este estudio, no es posible determinar la significación de las diferencias mediante estadística inferencial, lo cual hubiera servido para determinar la significación estadística de estas impresiones.

Discusión

Respecto al primer objetivo de investigación, enfocado en comparar el rendimiento académico de la última cohorte con entorno de aprendizaje totalmente presencial con la primera cohorte con entorno de aprendizaje totalmente online, teniendo en cuenta, no solo la evaluación final global, sino también los distintos componentes evaluativos que la componen, a pesar de que la tasa de éxito se sitúa sobre el 98% para ambas cohortes, se observa una mayor concentración de calificaciones altas en el caso de la primera cohorte, que alejan la distribución de calificaciones de la normalidad esperable, tomando como referencia la distribución de calificaciones de las materias del área. Parece razonable asumir entonces cierta anomalía en la distribución de dichas calificaciones. Tras considerar los diferentes factores que pudieran explicar esta diferencia, en consonancia con las conclusiones aportadas por el estudio de Sánchez-Cabrero et al. (2021a) , todo apunta hacia la excepcionalidad de la prueba final de la asignatura, lo que se pudo traducir en una inadecuación de ésta al entorno en que se produjo. Como ya se ha indicado, la docencia de la asignatura para esta cohorte fue presencial, pero una semana antes de la realización de la prueba final se decretó un confinamiento nacional que impidió realizar las pruebas finales de forma presencial.

Dado el protocolo existente en la facultad para la aprobación de las pruebas finales (requieren ser aprobadas por el departamento y por un examinador externo perteneciente a otra universidad) no hubo tiempo material para rediseñar, y revisar todas las pruebas finales de todas las asignaturas del grado para adecuarlas al entorno online. Ante esa situación de emergencia, el centro decidió mantener las pruebas diseñadas para un entorno presencial, a pesar de que iban a ser realizadas de forma remota, poniéndose todos los esfuerzos en ese momento en garantizar que todos los estudiantes pudiesen realizar las pruebas desde sus hogares. En el segundo semestre, tanto la docencia como las actividades de evaluación se diseñaron para un entorno online. El centro comunicó esta decisión con mucho tiempo de antelación, indicando que la decisión era definitiva e independiente del estado de confinamiento, o no, en el momento de realizar las pruebas. En este caso se desarrolló una prueba final de ‘libro abierto’, asumiendo que todos los estudiantes podían tener acceso a cuantas fuentes de información tuviesen a su alcance. Dadas las características de la prueba, los estudiantes dispusieron de cinco horas para su realización, en lugar de las dos horas de los exámenes presenciales, lo que encaja con las propuestas de Myyry y Joutsenvirta (2015) . Para garantizar la integridad, se introdujo un programa antiplagio en el sistema de entrega de la prueba final. Los resultados fueron excepcionales, y la prueba final diseñada fue destacada por el departamento, siendo tomada como referencia del tipo de evaluación deseable en el nuevo entorno.

Para confirmar que la anomalía en los resultados académicos de los estudiantes de la cohorte 1 presencial fue debida a la prueba final, basta con observar las distribuciones de las calificaciones obtenidas por ambas cohortes en los dos elementos que componen la calificación final, el proyecto (Figura 3) y la prueba final (Figura 4). La gran similitud en la distribución de las calificaciones del proyecto pone de manifiesto que el origen de la divergencia radica en la prueba final. La similitud en la distribución de las calificaciones del proyecto se confirma en el análisis estadístico presentado en la Tabla 3. Con la prueba de Levene se comprobó la existencia homocedasticidad (igualdad de varianzas) en las variables, pues dependiendo de si hay igualdad de varianzas o no, en la prueba t se usarán dos estadísticos de contraste diferentes. Teniendo en cuenta que la igualdad de varianzas se confirma cuando el grado de significación p-valor (Sig. en la Tabla 3) correspondiente a cada F es superior a 0,05, en este caso se confirma para el proyecto (0,512), pero no para el examen (0,03) ni para la calificación final (0,015). En la Prueba t para igualdad de medias, se confirma la igualdad para el proyecto (sig. bilat. de 0,905), mientras que se rechaza para el examen y la calificación final (sig. bilat. de 0).

El relativamente elevado porcentaje de estudiantes que no superan la prueba final en la segunda cohorte es consistente con el histórico de resultados en dicha prueba. El motivo es que en el momento de realizar la prueba final los estudiantes ya conocen sus calificaciones del proyecto, y dado que éstas suelen ser altas, algunos tienden a ajustar su esfuerzo en la preparación de la prueba final a la obtención del aprobado en la calificación final (por normativa de la universidad no está permitido establecer calificaciones mínimas en los distintitos componentes de la calificación final). Como se puede observar en la Tabla 4, esto se traduce en una relativamente baja correlación entre las calificaciones de los proyectos y de los exámenes (0,209), muy inferior a la existente entre las calificaciones finales y las de los exámenes (0,930), pero también sensiblemente inferior a la que presentan las calificaciones finales con las de los propios proyectos (0,504).

Teniendo en cuenta la paridad de las tasas de éxito de ambas cohortes, y explicada la anomalía en la prueba final, los resultados obtenidos son coherentes con las conclusiones de Paul y Jefferson (2019) y Toyne et al. (2019) , quienes no encontraron diferencias estadísticamente significativas entre los resultados de los estudiantes de los entornos presencial y online. No obstante, sí que hubo diferencias estadísticamente significativas en el examen final, pero en consonancia con el estudio de Sánchez-Cabrero et al. (2021a) , las diferencias en rendimiento académico vienen justificadas por las circunstancias de diseño de la prueba evaluativa y las expectativas de los profesores sobre la evaluación, ya que hubo cambios destacables en este proceso (diferente duración del examen, no adaptación de las cuestiones al medio y medidas compensatorias derivadas de las circunstancias especiales de evaluación) que pueden explicar estas diferencias.

Respecto al segundo objetivo de investigación, consistente en evaluar si el cambio de entorno de aprendizaje ha variado la valoración del profesor y la interacción docente-alumno, y si estos factores han influido en el rendimiento académico. Lo primero que llama la atención es la diferencia en la tasa de respuesta. En la cohorte 1 presencial se situó en un 67% (84 de 125), mientras que en la cohorte 2 online fue de tan solo el 19% (30 de 157). No obstante, la explicación es sencilla. En el entorno presencial las encuestas se realizan durante la penúltima sesión (en ausencia del profesor), de manera que todos los estudiantes que están en clase en ese momento realizan la encuesta. Esta posibilidad no existe en el entorno virtual.

Los datos obtenidos de ambas cohortes son muy similares (Figura 5) y muestran con claridad como la percepción de los estudiantes acerca de la calidad de la asignatura y el docente apenas varió. En dos de las preguntas la valoración media fue la misma, en seis la diferencia de los resultados para ambas cohortes fue de tan solo una décima, y en una fue de dos décimas. La valoración media fue la misma (4 sobre 5). Estos valores, que indican que los estudiantes no percibieron en el nuevo entorno una disminución de la calidad, están en consonancia con las observaciones de Johnson et al. (2000) en su estudio, en la que observaron resultados muy similares en la valoración del docente en el entorno de aprendizaje online y presencial.

Comparando los resultados obtenidos con los recogidos en Johnson et al. (2000) se puede apreciar una sutil diferencia, pues en este trabajo se señala una percepción ligeramente más favorable del docente en el entorno presencial. En el caso del presente estudio, la valoración del docente es la misma en ambos entornos, lo que supone una mejor valoración relativa del docente en el entorno virtual si la comparamos con lo esperable del estudio anterior. El contexto excepcional (confinamiento motivado por una pandemia) en el que se desarrolló el proceso de enseñanza-aprendizaje de la cohorte 2 podría ser la explicación, pues la predisposición del alumnado hacia el nuevo entorno fue muy positiva desde el principio, mostrando en todo momento una gran empatía, y asumiendo la solución propuesta de cambio de entorno como la mejor de las alternativas posibles, lo que encaja con las conclusiones de Bączek et al. (2021) .

La información obtenida de las encuestas de valoración del profesor acerca de la interacción alumno-profesor en el nuevo entorno no es especialmente relevante debido a la reducida muestra, pues se limita a tres cuestiones. A pesar de ello, los resultados obtenidos (valor medio de 4,1) son consistentes con los del resto del cuestionario (media de 4,0). Esto significa que los tres aspectos analizados del nuevo entorno online se valoraron de manera similar al resto de aspectos reflejados en el cuestionario (Figura 6), lo que no altera la valoración conjunta del estudiante de forma estadísticamente significativa, lo cual está en la línea de las conclusiones de Alonso y Blázquez (2009) .

Dado el carácter limitado de la información aportada por las preguntas del cuestionario acerca de la interacción alumno-profesor en el nuevo entorno, podría ser útil ampliar esta información con los resultados de un estudio llevado a cabo a nivel institucional. A diferencia de los datos presentados hasta ahora, en este caso la información no proviene directamente de los estudiantes de la materia analizada, sino que lo hace de un estudio efectuado por el centro al finalizar el primer semestre con docencia en formato online con el fin de mejorar la calidad, y en el cual participaron tanto grupos de estudiantes como de profesores. En dicho estudio, entre otros aspectos, se recoge un uso excesivo de los emails para aclarar dudas, en detrimento de las sesiones de tutoría online, las cuales fueron poco utilizadas por los estudiantes. Los estudiantes manifestaron que era importante que el profesor definiese claramente el medio de comunicación en su asignatura, sin mostrar una preferencia clara entre el email y las comunicaciones a través de la plataforma virtual. Igualmente, se recoge la valoración positiva del uso de la herramienta ‘sondeos’ de la plataforma virtual durante las clases, por hacer las sesiones más participativas y ayudar a evitar distracciones. Los docentes se manifestaron en el mismo sentido en este aspecto, y destacaron la gran participación en el chat (hasta el punto de hacerse inmanejable por momentos) en contraposición a la baja participación oral. La información presentada en este estudio inicial puede ser útil de cara a diseñar procesos de enseñanza-aprendizaje más efectivos en entornos remotos, así como para desarrollar nuevas líneas de investigación.

El cambio de entorno de aprendizaje propiciado por la pandemia no ha tenido una influencia significativa sobre los resultados del aprendizaje en el caso presentado, si bien la distorsión en los resultados académicos de la prueba final de la cohorte 1 presencial evidencia la importancia de la adecuación de todos los elementos del proceso de enseñanza-aprendizaje al entorno en el que éste se produce, incluidas las estrategias e instrumentos para la evaluación. La calidad, medida a través de las valoraciones del profesor y de la asignatura reflejadas en las encuestas respondidas por los estudiantes, no se ha visto afectada por el cambio de entorno, y la interacción entre alumno y profesor no es percibida de una forma más negativa en el entorno virtual que en el presencial. No obstante, es importante prestar atención a la variedad de formas de comunicación que se presentan en el entorno online (email, mensajería a través del campus virtual, chats, foros, video-tutorías), pues la coexistencia de diferentes alternativas puede generar confusión entre los estudiantes y alejarlos del proceso.

La principal limitación de este estudio parte de que su realización se deriva de un suceso incidental y por ello no se han podido incluir y controlar todas las posibles variaciones metodológicas entre ambos entornos. No se disponen de datos demográficos de edad y sexo, y en los cuestionarios respondidos por los estudiantes los datos medios disponibles no permiten realizar los análisis estadísticos inferenciales oportunos. Como resultado de las limitaciones descritas, el estudio se podría ampliar en un futuro controlando y ampliando las variables de ambos entornos, de forma intencionada, desde el inicio de la investigación.

También podría resultar de interés ampliar la investigación incorporando los resultados de futuras cohortes que cursen la asignatura en su formato presencial original, y analizar en qué medida el cambio de formato inicialmente experimentado (de presencial a virtual) como consecuencia de la pandemia puede influir en la configuración del proceso enseñanza-aprendizaje en el momento en el que se retome el formato presencial. Igualmente, el análisis de los resultados en otras asignaturas de los mismos estudios dotaría de mayor solidez las conclusiones obtenidas.

Finalmente, se debe destacar su aportación a la comparativa entre la docencia y evaluación presencial u online, tanto al ámbito teórico como práctico. A nivel teórico se ha confirmado cómo la docencia online puede garantizar el aprendizaje y desarrollo de competencias al mismo nivel que la docencia presencial, incluyendo la calidad de las interacciones docente-alumno. Por otro lado, a nivel práctico se debe destacar que los procesos evaluativos deben ser adaptados a la modalidad de evaluación para no introducir variaciones en los resultados. El mayor riesgo evaluativo no descansa sobre la modalidad de evaluación, sino sobre las decisiones que se toman al respecto por parte de los docentes, que pueden introducir su sesgo relacionado con expectativas y miedos sobre la evaluación.