Introducción

La microenseñanza es una técnica para el entrenamiento y perfeccionamiento de las habilidades pedagógicas, se centra en la manera en cómo los maestros enseñan (técnica) y no en el que se enseña (contenidos) (Escoto, 2001). Consiste en simplificar las complejidades de una clase normal, disminuyendo el tiempo de exposición, la extensión del contenido y el tiempo de duración durante el entrenamiento (). Esta técnica tuvo sus inicios en la Universidad de Stanford en 1963 y con algunas adaptaciones se ha difundido internacionalmente (Dwight, 1967). Fue creada para abatir muchas de las deficiencias de los programas tradicionales de la educación de maestros, y para acrecentar el entendimiento del proceso que se establece entre el profesor y la enseñanza. (“”). Es un encuentro de enseñanza reducido que se ha desarrollado para servir a 3 propósitos: (1) como experiencia preliminar y práctica en la enseñanza, (2) como un vehículo de investigación para explorar los efectos del entrenamiento bajo condiciones controladas, y (3) como un instrumento de capacitación en servicio para maestros experimentados. Se les exige que enseñen lecciones breves (5 a 25 minutos) en su materia, a un grupo pequeño de estudiantes (hasta 5). Estas breves lecciones brindan la oportunidad de una supervisión intensa, grabación de video para comentarios inmediatos y la recopilación y utilización de comentarios de los participantes ().

Para le recopilación de información de los estudiantes se han diseñado instrumentos o cuestionarios para evaluar la técnica de la microenseñanza. Entre ellos existe gran diversidad de modelos, habilidades didácticas empleadas, número de preguntas, población aplicada y diseño para la validación de cada uno de éstos, aplicados en diferentes áreas.

Al respecto, Dwight (1967), elaboró un cuestionario de 35 preguntas para los estudiantes universitarios (docentes de recién ingreso) dividido en 7 habilidades de enseñanza (reforzamiento, variación de estímulos, inducción, lectura y uso de medios audiovisuales, habilidad de explicación y uso de ejemplos y preguntas iniciadas por los alumnos), en donde cada pregunta tiene siete niveles de acuerdo con una escala de Likert. No se establece una validez y confiabilidad, solo se menciona que se obtuvieron resultados estadísticamente significativos (p= 0.001). Guillermo (1997), diseñó un instrumento de 24 preguntas aplicado a docentes de la licenciatura en docencia, dividido en tres habilidades didácticas (reforzamiento, formulación de preguntas e integración), considerando 5 niveles de calificación de acuerdo con la escala de Likert, sin mencionar confiabilidad ni validez del instrumento empleado.

Por otro lado, Capa en 2005, validó la versión turca del cuestionario Teachers´s Sense of Efficacy Scale aplicado a docentes en formación en educación, que está conformado por 24 preguntas, dividido en 3 dimensiones (eficacia en la participación de estudiantes, eficacia en las estrategias de instrucción y eficacia en la gestión del aula), con 9 niveles de calificación de acuerdo con la escala de Likert. Obtuvo una alfa de Cronbach de 0.82, 0.86 y 0.84 para cada una de las habilidades y una confiabilidad del instrumento de 0.93, empleando análisis factorial exploratorio.

El cuestionario de Watson (2007), cuenta con 28 preguntas para docentes nuevos de la Universidad de Ciencias Aplicadas, organizadas en 4 competencias (diseña y desarrolla secuencias de clase que promueven un aprendizaje significativo, creativo y activo; elabora y utiliza medios y materiales de enseñanza y aprendizaje, haciendo uso efectivo de la tecnología educativa y de las TIC; se comunica de forma efectiva involucrando a los alumnos en el tema desarrollado y mantiene una buena relación con los alumnos durante el proceso de enseñanza y aprendizaje) y Deniz (2011), empleó un cuestionario para profesores en formación de un Programa de Desarrollo Infantil, que mide las opiniones sobre las habilidades de enseñanza, considerando 5 habilidades didácticas (planeación y preparación para la lección, gestión del aula y relación con los estudiantes, empleo de métodos de enseñanza, implementación del proceso de enseñanza y evaluación), en 31 preguntas, con cinco niveles de calificaciones de acuerdo a la escala de Likert con una confiabilidad alfa del cuestionario del preexamen de .94 y post examen .91.

Otro instrumento reportado es el de las , cuyo cuestionario aplicado a profesores, está conformado por 31 preguntas, dividido en 7 habilidades didácticas (inicio y motivación, comunicación verbal y no verbal, variación del estímulo, formulación de preguntas, integración de saberes, organización lógica y cierre de clase (refuerzo)), con 5 niveles de calificación en escala de Likert, aunque no se específica la validez ni confiabilidad del instrumento. Se reportan dos cuestionarios más, el de Remesh (2013) que consta de 39 preguntas aplicado a profesores principiantes en la Carrera de Medicina, muy parecido al de la Universidad de Stanford (Dwight, 1967), que está dividido en 8 habilidades de enseñanza (planeación de clases, presentación y explicación, ilustrar con ejemplos, reforzamiento, variación del estímulo, preguntas de sondeo o exploración, manejo de clase y uso de medios audiovisuales), sin mencionar análisis de validez y confiabilidad; y la otra propuesta es de , que consta de 19 preguntas aplicado a estudiantes de la Especialidad en Tecnología del Vestido, dividido en tres dimensiones (planificación, conducción y evaluación), 5 niveles de calificación en una escala de Likert, con una validez por juicio de expertos de 88% y coeficiente de confiabilidad de Cronbach del instrumento de 0.96.

Recientemente Dayanindhi (2018), empleó un instrumento similar al utilizado en la Universidad de Stanford (Dwight, 1967), aplicado a profesores médicos en servicio, contiene seis dominios (inducción, planeación, presentación, uso de medios audiovisuales, participación de los alumnos y cierre), con 19 preguntas, aunque no se menciona la validez y confiabilidad del cuestionario. Con base en lo anterior se puede observar que la mayoría de los instrumentos no tienen evidencias de validez y confiabilidad y fueron diseñados exclusivamente para uso local.

Por otro lado, la Carrera de Química Farmacéutico Biológica (Q.F.B.) de la Facultad de Estudios Superiores (FES) Zaragoza de la Universidad Nacional Autónoma de México (UNAM) ha realizado por varios años procesos de evaluación de la docencia, y ha implementado diferentes estrategias con la finalidad de fortalecer estas evaluaciones, como proponer cursos de actualización docente, cursos de formación pedagógica, estímulos académicos, entre otras acciones para mejorar el desempeño académico de los docentes en el aula de clases. Dentro de estas estrategias se ha propuesto la implementación de la técnica de la microenseñanza como una alternativa práctica que permita mejorar las habilidades didácticas y pedagógicas de los docentes de la carrera. Para conocer si se consigue lo anterior es necesario contar con un instrumento válido y confiable que permita evaluar las mejoras en las habilidades didácticas que presentan los profesores al aplicar la técnica de la microenseñanza, mediante la opinión de los estudiantes.

Es importante señalar que en el proceso de evaluación de la docencia se aplica un cuestionario de 22 preguntas de las cuales 9 consideran las habilidades didácticas de los docentes ( propicia el interés de los alumnos por los temas, promueve la participación de los alumnos, Fomenta el uso de las tecnologías de la información y comunicación (TIC), Prepara las clases, Relaciona la teoría con la práctica, asesora al alumno en las actividades propuestas, propicia el trabajo colaborativo entre los alumnos, genera un ambiente de confianza durante las actividades académicas y domina los contenidos del programa) y son lo que más se acerca a dichas habilidades en la técnica de la microenseñanza, pero no evalúan todos los aspectos que la conforman ( ).

Con base en lo anterior, se consideró importante contar con un instrumento de evaluación de la microenseñanza válido y confiable que tome en cuenta la opinión de los estudiantes como parte sustancial de los procesos de enseñanza y aprendizaje, y que además sea adecuado y pertinente para ser aplicado en la carrera de Q.F.B. de la FES Zaragoza, UNAM.

Un aspecto muy importante a considerar es la validez de acuerdo en la evidencia basada en las consecuencias de las pruebas, a este respecto Martínez Rizo et al., 2015 (citado en Taut, 2016) indican un conjunto de criterios de buena práctica en la validación, entre los que se pueden mencionar los siguientes: Contar con argumentos lógicos y evidencia empírica que respalde los usos y consecuencias previstas; evaluar el grado en que se producen las consecuencias previstas y/o deseables de la prueba; la difusión de los resultados en tiempos razonables, sin discriminación; informar a los usuarios sobre los propósitos y características de las pruebas; utilizar lenguaje claro y preciso sin tecnicismos; describir el perfil y características de la población de referencia; Identificar los usos o interpretaciones inadecuadas de la prueba e investigar en detalle cuando exista evidencia confiable de usos inapropiados.

Método

Diseño

Este estudio empleo un muestreo no probabilístico por oportunidad, en donde la elección de los elementos no depende de la probabilidad sino de las características de la investigación. ( ).

Participantes

En este estudio participaron cinco docentes con estudios de posgrado en educación o en educación superior, con más de 20 años de experiencia en el área educativa en las carreras de la FES Zaragoza. La muestra de estudiantes fue 124, de diferentes semestres de la carrera de Q.F.B. de la FES Zaragoza UNAM (con un rango de edad entre los 18 y 24 años, con una participación del sexo femenino del 51.22% y de hombres del 48.78%, y con un nivel socioeconómico de un ingreso menor a 4 salarios mínimos). Los criterios de selección fueron: a) inscritos oficialmente en el semestre que cursaban, 2) que quisieran participar en el proyecto. El 17.7% de los estudiantes cursaban el tercer semestre, el 30.6% el quinto semestre, el 5.6% el octavo semestre, el 26.6% el noveno semestre y el 19.4% el décimo semestre. Así mismo, el 54.8% de los estudiantes se encontraban en clases teóricas (la cual consiste en la presentación de un tema, lógicamente estructurado, en donde el recurso principal es el lenguaje oral, en donde la información debe activa r los conocimientos previos, presentar los contenidos en forma activa y estructurar los contenidos ( ) y el 45.2% en prácticas de laboratorio ( la cual tiene como objetivo que los estudiantes adquieran las habilidades propias de los métodos y técnicas de trabajo y de la investigación científica; amplíen, profundicen, consoliden, generalicen y comprueben los fundamentos teóricos de la disciplina mediante la experimentación, empleando para ellos los medios necesarios ()

Instrumentos

Cuestionario de Evaluación de la Microenseñanza (CEM)

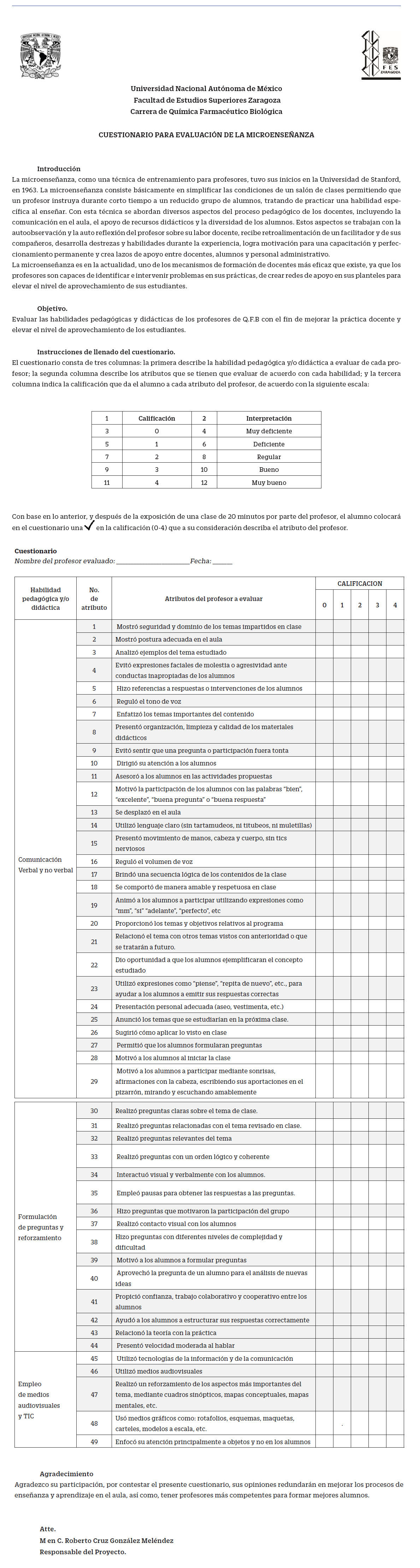

Para el diseño y estructuración de las habilidades didácticas y sus niveles de calificación del CEM se consultaron a autores como: Dwight, A (1967); ; Capa, (2005); Watson, (2007); ; ; Remesh, (2013); ; Dayanindhi, (2018). Así mismo, se consideraron las nueve preguntas de la habilidad didáctica contenida en el Cuestionario de Evaluación de la Docencia aplicados en la Carrera de QFB, en la FES Zaragoza de la UNAM.

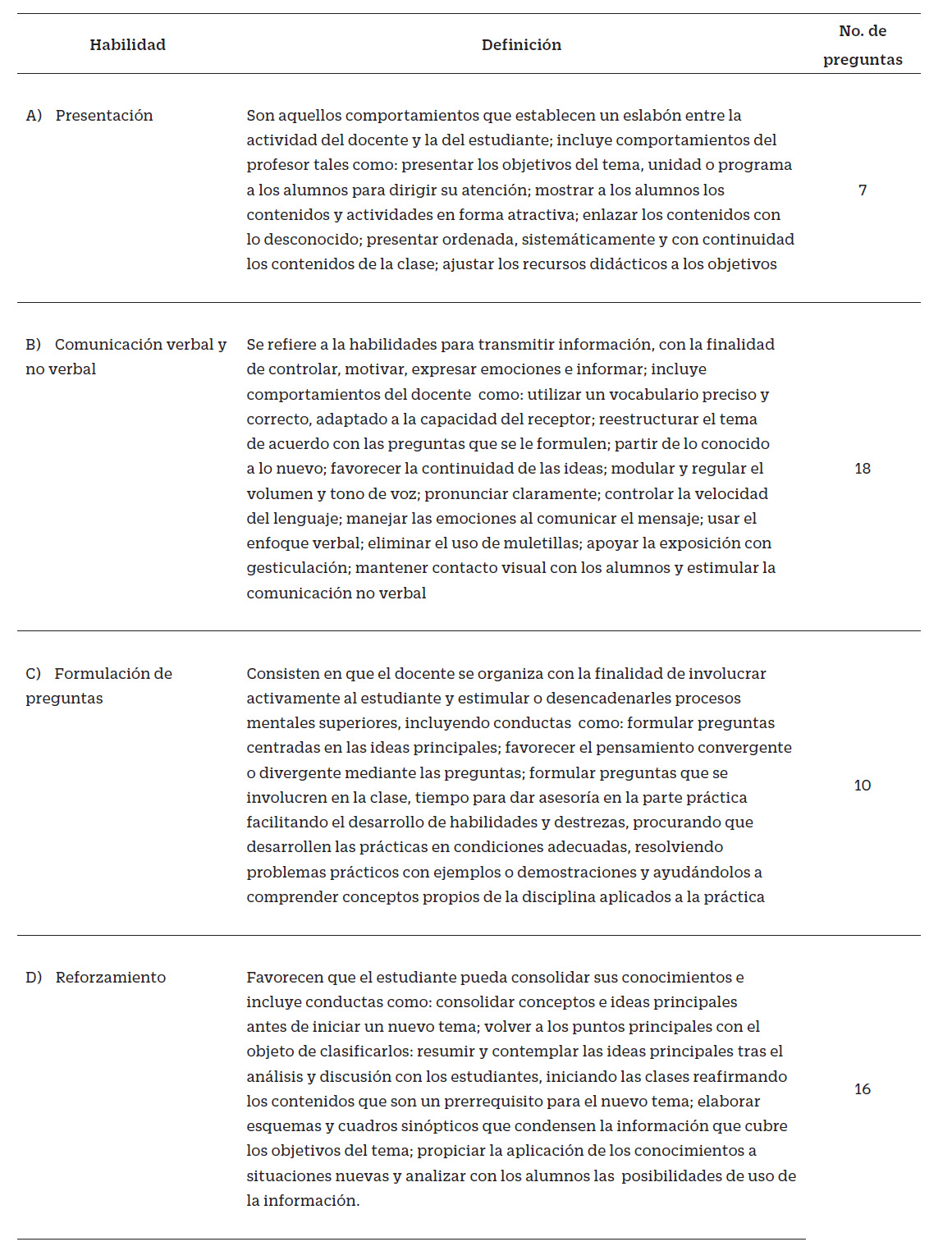

Con base en lo anterior, el CEM contempló cuatro habilidades didácticas para la evaluación de la microenseñanza, con diferentes números de preguntas, considerando 5 niveles de calificación para cada una de las preguntas (0=nunca, 1=casi nunca, 2=algunas veces, 3= frecuentemente, 4=siempre). Las definiciones de cada una de las habilidades didácticas de acuerdo con Escoto (2001), se describen en la tabla No. 1.

Instrumento de Opinión sobre el Cuestionario de Evaluación de la Microenseñanza (IOCEM).

Con la finalidad de determinar si cada una de las preguntas incluidas, así como los apartados fueran entendibles para los alumnos, se diseñó el IOCEM, con base en las preguntas de cada una de las habilidades didácticas incluidas en el CEM y la experiencia de los investigadores.

Procedimientos

El primer paso fue crear la versión uno del CEM, con base en los cuestionario de microenseñanza de diversos autores y los nueve preguntas de la habilidad didáctica contenida en el Cuestionario de Evaluación del Estudiante al Ejercicio Docente aplicado en la carrera QFB de la FES Zaragoza. El segundo paso fue llevar a cabo la validación del contenido por cinco profesores expertos en educación superior, quienes analizaron y emitieron sugerencias y observaciones para mejorar el CEM en contenido, estructura, congruencia, redacción y niveles de calificación, dando origen a la versión dos del CEM. El tercer paso fue que con base en esta versión y con la experiencia de los investigadores, se propusieron preguntas para conformar el IOCEM. Después de un análisis de cada propuesta de obtuvo el cuestionario final con 8 preguntas, que permitió recabar la opinión de los estudiantes sobre la claridad y entendimiento de la introducción, objetivos, escala de calificación, y redacción, así como, la extensión y utilidad del CEM.

El cuarto paso fue realizar la validación del constructo y confiabilidad del CEM, para ello se extendió una invitación por escrito a varios profesores de la carrera de Q.F.B. a quienes se les explicó el propósito, objetivo del estudio y las habilidades didácticas que se evaluarían con base en el CEM, solicitándoles su autorización para asistir a una clase de 20 minutos, y posteriormente llevar a cabo la aplicación del CEM y del IOCEM a sus alumnos. En el aula se explicó a los estudiantes el propósito del estudio, así como, el objetivo de su participación al evaluar la técnica de la microenseñanza del docente mediante la aplicación del CEM, y el objetivo del IOCEM. Es importante mencionar que la aplicación de los cuestionarios fue de forma anónima para evitar cualquier tipo de coerción por parte de los docentes evaluados, por lo que a los estudiantes participantes se les asignó un número conforme fueron entregando los cuestionarios resueltos. Cabe señalar que el compromiso con los profesores fue hacerles entrega por escrito de los resultados obtenidos de la evaluación de sus alumnos.

El quinto paso fue el tratamiento estadístico de los datos mediante el Análisis Factorial Exploratorio, Alpha de Cronbach, dando origen al versión tres y final del CEM, y análisis de frecuencias para el IOCEM

Es importante mencionar que cada uno de los profesores participantes firmaron un consentimiento informado, en donde se dieron a conocer el objetivo y propósito de la participación de cada uno de ellos en el proyecto, la solicitud para asistir a una clase de 20 minutos, el compromiso de mantener la confidencialidad de la información derivada de la investigación, así como el aviso de privacidad de los datos personales.

Análisis de datos

Para determinar la validez del contenido del CEM se hizo mediante el juicio de expertos (face validity) con un análisis de los comentarios sobre los apartados del instrumento, las preguntas, ubicación de estas en cada habilidad didáctica, la escala de calificación, redacción y claridad del cuestionario. Para determinar la confiabilidad del CEM se utilizó el alfa de Cronbach. Para la validez del constructo se empleó Análisis Factorial Exploratorio mediante el programa SPSS V21 (IMB SPSS statatistics Armomk, NY, EU). Para el IOCEM se realizó mediante análisis de frecuencias.

De acuerdo a Hernández, 2010, el Alpha de Cronbach se interpreta con los siguientes valores: 0.25 en la correlación o coeficiente, esto indica baja confiabilidad; si el resultado es 0.50, la fiabilidad es media o regular. En cambio, si supera el 0.75 es aceptable, y si es mayor a 0.90 es elevada.

Para el AFE se realizó siguiendo cuatro fases: la primera fue determinar la matriz de correlación mediante la prueba de esfericidad de Barlett, que indica que los datos de todas las variables (preguntas) se correlacionan entre sí, y la media de la adecuación de la muestra Kaiser-Meyer-Olkin (KMO) (Aguilar 2003). Kaiser y Rice (1974) ( do en Ferrando, 2022) propusieron el índice KMO que establece que, a mayor valor del índice, más comunalidad disponible en la matriz de correlación. Se han sugerido toda una serie de valores para cualificar la cantidad de la comunalidad disponible; solo matrices con valores de KMO superiores a .75 merecen ser estudiadas mediante Análisis Factorial. La fase dos fue la estimación de factores la cual se realizó mediante un Análisis Factorial Exploratorio (AFE) utilizando el método de factorización de eje principal. La siguiente fase fue la extracción de factores, empleando para ello el Análisis Paralelo (AP) ( ), además, se consideró el “criterio de contraste de caída “(Hair, 1999) o “gráfico de sedimentación (López. 2015), tomando el número de factores a extraer determinado por el cambio en la continuidad en la curva. La siguiente etapa fue la rotación de factores, empleando una rotación oblicua, mediante el método Promax, empleando como valor de saturación de los ítems de 0.35, lo que representa la correlación entre la variable original y su factor (Spector, 1992).

En la última etapa se realizó por parte de los investigadores, un análisis conceptual sobre la agrupación y congruencia de la variable para definir el significado de cada uno de los factores o habilidades didácticas, posteriormente, se reorganizaron y renombraron las habilidades didácticas, considerando que definieran al constructo de la microenseñanza.(Morales, 2011).

Resultados

Validez

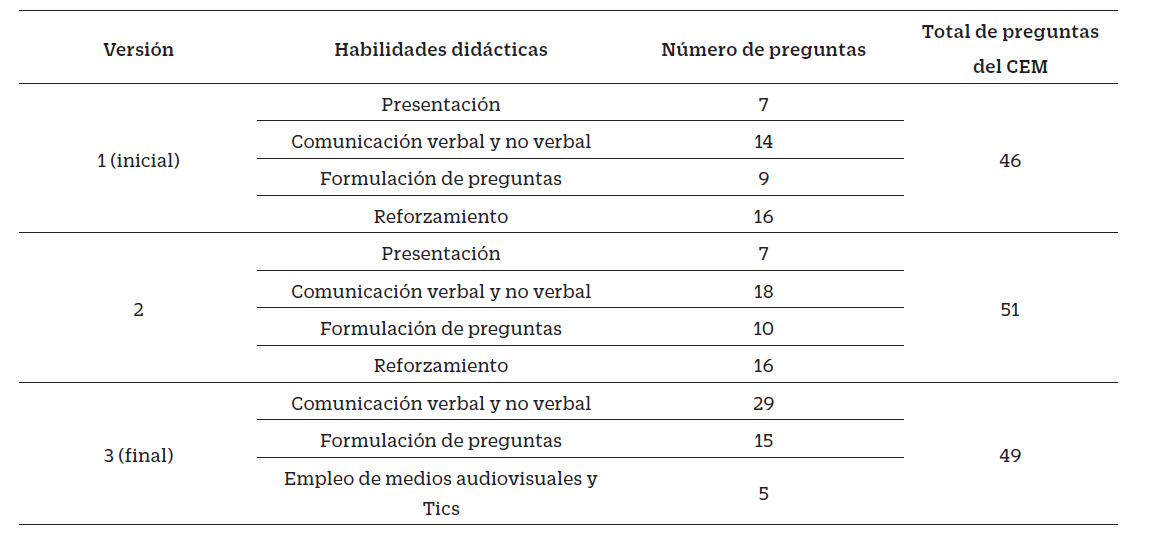

Para la validación de contenido, las observaciones realizadas a la versión 1 del CEM por parte de los docentes expertos, 7 de las preguntas permanecieron sin cambio (15.2%), 38 preguntas (82.6%) presentaron cambios en su redacción principalmente en la conjugación de verbos, en algunas de estas preguntas se cambió la redacción para hacerlas más entendibles y sólo una pregunta (2.1.%) fue eliminada. Así mismo, fueron adicionadas 6 preguntas nuevas: 4 en la habilidad de comunicación verbal y no verbal y 2 en la habilidad de formulación de preguntas. Se cambiaron los niveles de calificación de las preguntas por: 0=muy deficiente, 1= deficiente, 2= regular, 3=bueno y 4=muy bueno. Con base en lo anterior, se conformó la versión 2 del CEM con 51 preguntas, con 4 habilidades didácticas, como se observa en la tabla 2.

Para la validación de la estructura interna se aplicó el CEM y simultáneamente el IOCEM, a 6 grupos ( 3 grupos de actividades prácticas y de 3 de actividades teóricas) con una participación de 124 alumnos. Los resultados del AFE del CEM son los siguientes:

En la matriz de correlación se observó una distribución normal, la prueba de esfericidad de Barlett indicó que todas las variables se correlacionan entre sí (p< 0.0001), y el KMO cumplió con el criterio para realizar un AFE con un valor de 0.897.

La estimación de factores realizado por el método de factorización de eje principal se observó una distribución de las preguntas en 11 factores.

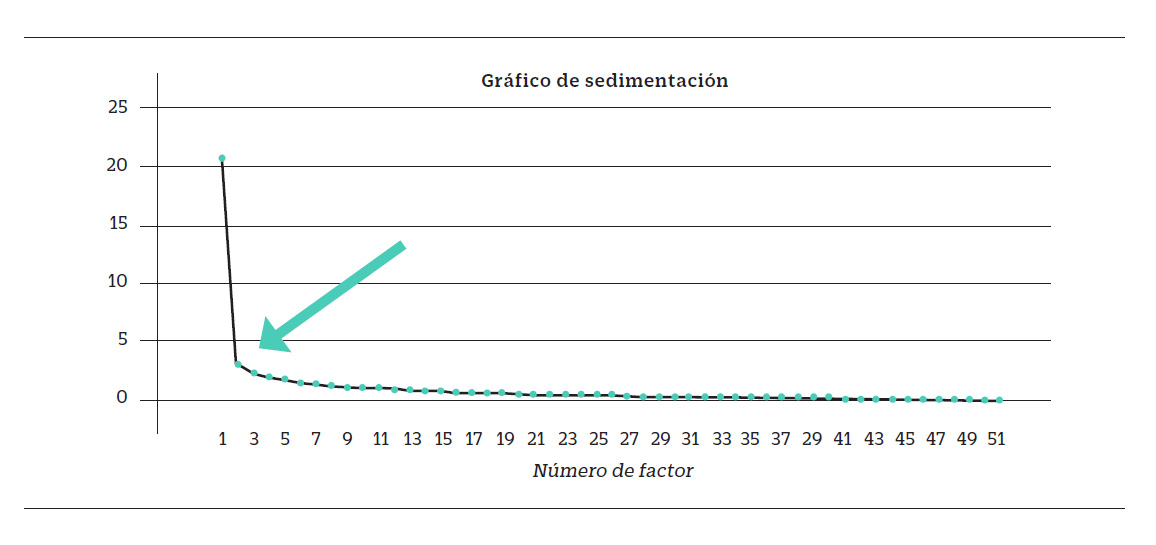

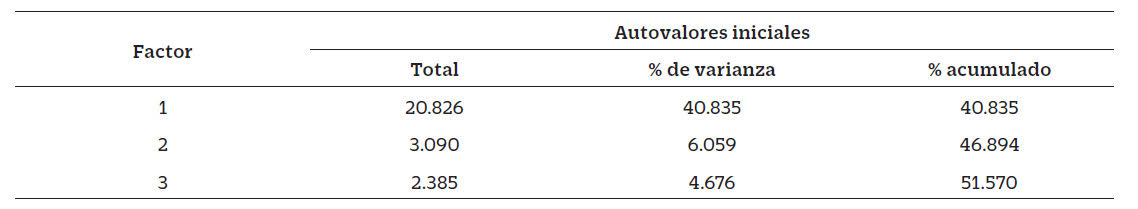

Para la extracción de factores se empleó el Análisis Paralelo (macro de SPSS, ( )) y el gráfico de sedimentación (fig. 1), dando como resultados la distribución de las preguntas en tres factores. En la tabla se muestra que la varianza acumulada para los tres factores fue del 51.57% (Tabla 3)

Tabla 3 Varianza total explicada para tres factores.

Método de extracción: factorización de eje principal

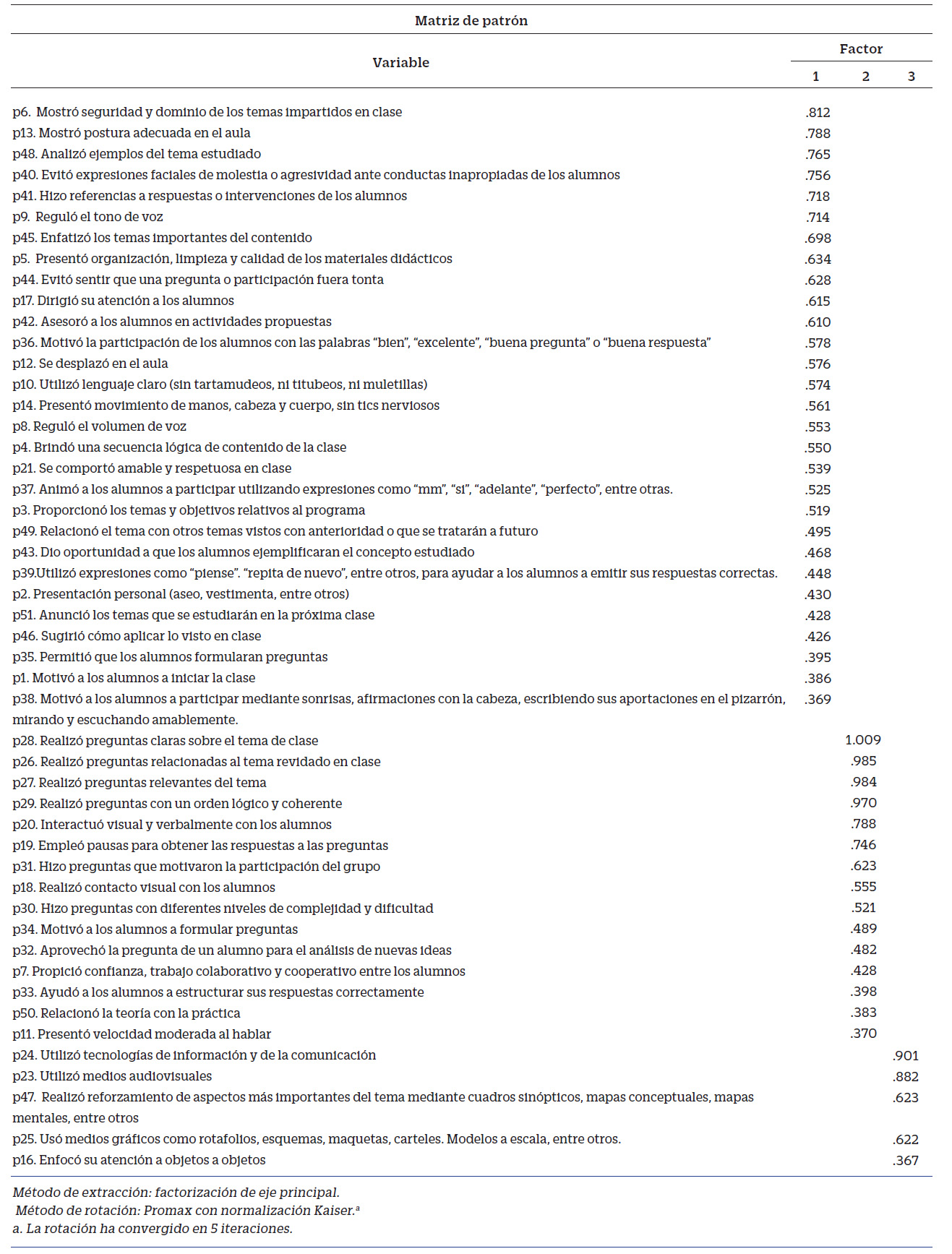

Los resultados de la rotación oblicua mediante el método Promax, se observa en la matriz patrón (Tabla 4).

En la tabla 4 se muestra el resultado de la rotación oblicua de la matriz patrón de tres factores para determinar el número de variables (preguntas) para cada factor. Las preguntas “Utilizó gestos para conducir al grupo /gesticulación del rostro)” y “utilizó pizarrón” fueron eliminadas debidos a que tuvieron cargas factoriales menores 0.35.

Con base en los resultados del AFE, y la experiencia de los investigadores se reagruparon y nombraron los factores o habilidades didácticas, dando origen al versión 3 de CEM con 49 preguntas, distribuidas en 3 factores: Factor 1 se denominó “ Comunicación verbal y no verbal con 29 preguntas (40.83% de varianza); Factor 2 de acuerdo a los ítems que lo integraron se llamó “Formulación de preguntas y reforzamiento” integrado por 15 preguntas (6.05% de varianza) y al factor 3 de acuerdo a los preguntas que los integraron se denominó “Empleo de medios audiovisuales y las TIC” con 5 preguntas (4.67 de varianza). Lo anterior dio origen a la versión 3 y final del CEM. (Tabla 5).

El tiempo que tardaron en contestar los alumnos el CEM y el IOCEM fue en promedio de 28 minutos.

Confiabilidad

El valor de la confiabilidad del alfa de Cronbach para el CEM fue de 0.961.

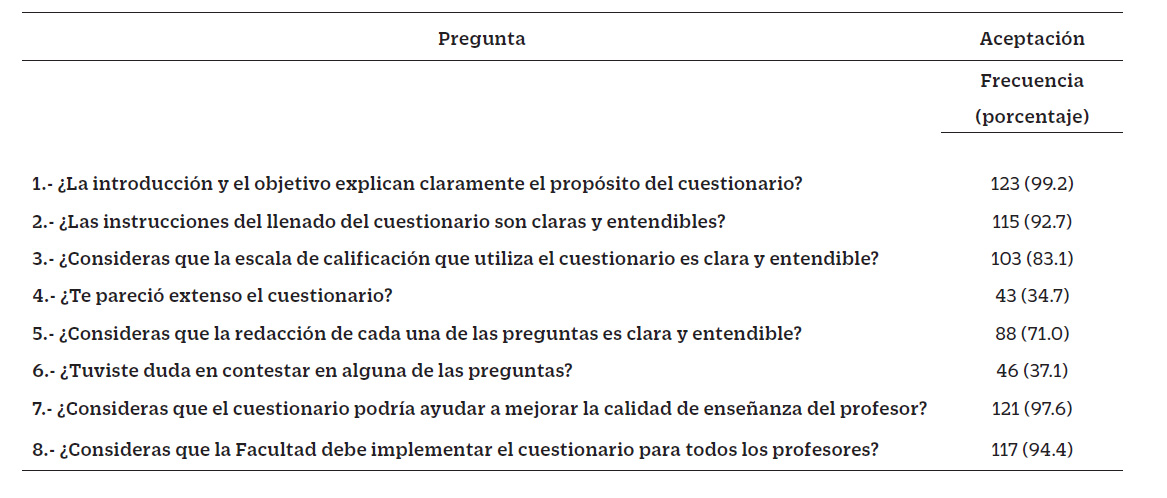

En relación con la claridad y entendimiento del IOCEM (preguntas 1, 2, 3 y 5) se obtuvo una aceptación superior al 85%, (a 1 de cada 3 alumnos le pareció extenso), del 37.1 % de los estudiantes que tuvieron duda al contestar el cuestionario, la pregunta 16 tuvo un 65.2% de duda, seguida de la pregunta 44 con un 6.52%, y se obtuvo una aceptación superior al 90% para mejorar la calidad de la enseñanza y para ser aplicado a los profesores de la FES Zaragoza. (Tabla 6).

Discusión

La evaluación de la docencia es un proceso complejo en donde el papel de los estudiantes es importante y necesario, además, la inclusión de diferentes técnicas pedagógicas para impartir los contenidos de un programa académico, como la microenseñanza, es un punto dentro de algunos planes institucionales en México ( ; ). Particularmente, la evaluación del proceso de microenseñanza requiere que se tomen en cuenta diferentes habilidades didácticas (Dwight, 1967), considerando como una actividad importante en este momento el uso de las TIC, por lo que contar con instrumentos actuales, válidos y confiables para ser resueltos por estudiantes, y tener parámetros de comparación y retroalimentación, tanto para el docente como para el personal encargado de la parte académico-administrativa, es un punto ineludible a nivel educativo.

En el diseño del CEM del presente trabajo se buscó que tuviera congruencia con los nueve aspectos incluidos en la habilidad didáctica en el cuestionario de la Evaluación de la Docencia aplicado en la Carrera de Q.F.B., en FES Zaragoza, y que, además, la redacción fuera clara y entendible (Morales, 2011) para que estudiantes y docentes lo comprendan de la misma manera.

El CEM diseñado quedó conformado por 49 preguntas en 3 habilidades didácticas: comunicación verbal y no verbal, formulación de preguntas y reforzamiento, y empleo de medios audiovisuales y las TIC. En este sentido, el número de habilidades didácticas en los instrumentos propuestos con anterioridad son diferentes para cada autor. y Toro (2017) consideran tres habilidades, la Universidad Rafael Landivar (2010) propone 6, Dayanindhi (2018), y sugieren 7 y indica 9 habilidades didácticas, por lo que este instrumento está acorde con el mínimo de habilidades a evaluar según los diferentes estudios.

Analizando por habilidad evaluada, la de comunicación verbal y no verbal es considerada por Watson (2007), la , y las U ; la habilidad de formulación de preguntas la proponen la Universidad Rafael Landívar (2010) y las Unidades Tecnológicas de Santander (2011); y la de reforzamiento la contemplan , la Universidad Rafael y Remesh (2013) y , y finalmente la habilidad de empleo de medios audiovisuales y las TIC es considerada por Remesh (2013) y Dayanindhi (2018); información que fue tomada en cuenta para el desarrollo del CEM. Cabe resaltar que esta última habilidad es de reciente inclusión debido a los avances tecnológicos y, en este momento, por la necesidad de su uso debido a la situación de contingencia mundial en la que nos encontramos debido a la pandemia de la COVID-19.

En lo referente a la extensión del cuestionario es muy variable, reportándose en un rango de entre 19 () y 38 preguntas ( ), lo que haría que el CEM sea un poco más extenso. Sin duda, las habilidades didácticas consideradas en cada instrumento, así como el número de preguntas en cada uno, dependerán en gran medida de los objetivos, propósitos y alcances de cada investigación. comenta que no hay un número óptimo de preguntas, pero a mayor número inicial de preguntas se tendrá una mayor probabilidad de encontrar en el análisis un conjunto de preguntas definitivas con una fiabilidad suficientemente alta. En cuanto al tiempo aplicación se consideró adecuado dado la extensión del CEM.

Para la validez de contenido con las aportaciones proporcionadas por los expertos se realizaron mejoras importantes para dar lugar a un cuestionario con una estructura, pertinente, bien definida, con una secuencia lógica, redacción clara y congruente con el objetivo del instrumento, con niveles de calificación adecuados para cada pregunta, logrando que fuera entendible para ambos actores del proceso de enseñanza-aprendizaje. La validez del constructo fue a partir de la opinión de los alumnos. Este estudio es coincidente con el de , ya que la aplicación del instrumento fue a estudiantes propiamente a diferencia de los demás reportes que aplicaron sus instrumentos a docentes nuevos o en formación.

Para el diseño del IOCEM, se buscó que la estructura y redacción, fueran claras y entendible (Morales, 2011) para los alumnos y docentes, y permitiera recabar información sobre opinión de cada apartado (introducción, objetivo, instrucciones de llenado, niveles de calificación y preguntas) del CEM.

Es importante señalar que ninguno de los autores consultados refiere la aplicación de un instrumento como el IOCEM (Dwight 1967; ; ; ; Remesh 2013; ; , el cual recaba la opinión de los alumnos sobre un cuestionario de evaluación.

Se considera a los alumnos como las mejores fuentes de información del proceso de enseñanza y aprendizaje, y son de quienes, mediante su opinión, se obtienen resultados del desempeño del docente en el aula a través del tiempo ( ). La percepción que tienen los estudiantes sobre su aprendizaje provee una medida de la acción docente, relacionada con los efectos que tiene esa acción en su experiencia de instrucción, por lo que es capaz de reconocer en que proporción la actividad del docente afecta su aprendizaje. (Acevedo, 2003).

Es importante mencionar que la metodología de obtener información en los procesos de enseñanza y aprendizaje a partir de la opinión de estudiantes no es el único, pero si es de los más utilizados y antiguos, y en el ámbito universitario es el de mayor difusión, reconocimiento y confiabilidad (Gómez, 2009).

El CEM demostró una validez y confiabilidad estadística. Las 49 peguntas tuvieron una distribución normal de acuerdo con lo que establece Castañeda, 2010, mientras que otros autores no refieren este supuesto (Dwight 1967; ; ; ; Remesh 2013; ; ). Así mismo, todas las variables tienen relación entre sí, al encontrarse una alta correlación entre todas las preguntas (variables), a diferencia de lo reportado en algunas investigaciones que no refieren ningún dato sobre esta prueba ( ; Guillermo 1997; , ; , ; Dayanindhi 2018). Solamente () reporta un valor de la prueba de esfericidad de Bartlett significativa (p < 0.001), semejante a lo encontrado en este trabajo.

Con relación a la extracción de factores, se realizó mediante un Análisis Paralelo y el método del gráfico de sedimentación, en donde el eje X se encuentra el número de ítems y en el eje Y los autovalores o varianza explicada para cada factor obteniéndose tres factores. Es importante mencionar que el AP es el método que se recomienda para la extracción de factores ( ; Ferrando, 2022). .En este sentido la mayoría de los estudios anteriores no refieren ningún dato o información al respecto (Dwight 1967; ; ; ; Remesh 2013; ; Dayanindhi 2018); sin embargo, Mergler (2010), empleando el método de componente principales, considerando 12 variables, reporta dos componentes que explicaron el 65% de la varianza, los cuales son eficacia del profesor en el aula con el 22% de la varianza y eficacia personal del mismo con el 32% de la varianza.

Es importante mencionar que en este estudio se utiliza el método de “factorización por eje principal” y se empleó la rotación oblicua, utilizando el método promax, los cuales son recomendados para el análisis factorial en el ámbito social. ( ). En el presente trabajo el primer factor encontrado fue la habilidad de “comunicación verbal y no verbal”, con una varianza explicada del 40.83% y 29 variables, siendo 14 preguntas al inicio del estudio. Esta habilidad fue considerada en los reportes de las , y de manera implícita en Watson (2007) en la competencia 3 “Se comunica de forma efectiva involucrando a los alumnos en el tema desarrollado” y la en la habilidad de “refuerzo verbal y no verbal”.

El segundo factor fue la habilidad de “formulación de preguntas y reforzamiento” con 15 variables o preguntas. Al respecto, en la versión inicial del cuestionario estas habilidades estaban separadas, de tal manera, que la formulación de preguntas estaba conformada por 9 preguntas y el de reforzamiento tenía 16 preguntas. Al respecto, esta habilidad ha sido contemplada con anterioridad como un elemento a evaluar en los estudios de Dwight (1967) Guillermo (1997), , Remesh (2013), y en el trabajo de la que lo toma en cuenta de manera implícita en la “habilidad para hacer preguntas y conseguir respuestas orales”.

El tercer factor fue la habilidad de “empleo de medios audiovisuales y las TIC”, una nueva habilidad que surgió como resultado del análisis factorial, la cual contó con 5 variables que se ha encontrado en los estudios más recientes debido a la naturaleza de la habilidad evaluada. ( , y Dayanindhi 2018).

Estos tres factores fueron corroborados a través de la carga factorial ya que las preguntas incluidas en cada factor presentaron un valor de correlación mayor a 0.35 acorde con lo estipulado por Spector (1992) y semejante a la propuesta de Tabachnick y Fidel ( ). En este sentido, Thurstone (c en De la Fuente, 2011) menciona que la matriz de cargas factoriales debe reunir tres características: cada factor debe tener unos pesos altos y los demás próximos a cero; cada variable no debe estar saturada más que en un factor; y no deben existir factores con la misma distribución, esto es, dos factores distintos deben presentar distribuciones diferentes de cargas altas y bajas. De esta manera cada factor tendrá una correlación alta con un grupo de variables y baja con el resto de las variables; de aquí que el CEM cumplió perfectamente con las características descritas por Thurstone.

Por otro lado, el cuestionario mostró un alto grado de confiabilidad respecto a las tres habilidades didácticas al ser utilizado por estudiantes, indistintamente del semestre que cursan y si están evaluando docentes de teoría o de actividad práctica, con un valor de alfa de Cronbach igual a 0.961. reportó un alfa de Cronbach igual a la obtenida en el presente estudio, así como indicó una confiabilidad semejante con el instrumento aplicado en su investigación. Otros estudios no mencionan ninguna información referente al valor de la confiabilidad de los instrumentos empleados (Dwight, 1967; Guillermo, 1997; Watson 2007; ; ; ; y Dayanindhi, 2018).

Como se puede apreciar, aunque son varias las propuestas de instrumentos para la evaluación de los docentes que se desempeñan en el campo de la microenseñanza, pocos son los que han obtenido los parámetros de validez y confiabilidad como en el presente estudio, además, de considerar en su diseño y evaluación la opinión directa de los estudiantes. De acuerdo con los resultados obtenidos podemos señalar que el CEM es válido y confiable para su uso con estudiantes en la evaluación de docentes, siendo un instrumento que mide el constructo de la microenseñanza.

Conclusiones

Con base en lo anterior se puede decir que el Cuestionario de Evaluación de la Microenseñanza que incluye la comunicación verbal y no verbal, la formulación de preguntas y el reforzamiento, además del empleo de medios audiovisuales y las TIC es válido y confiable, y puede ser aplicable en la población estudiantil de la carrera de Q.F.B. o cualquier otra semejante. De acuerdo con la validez consecuencial, el CEM, se aplicó sobre una población estudiantil con un perfil establecido, que fue informada sobre los objetivos y propósitos del CEM, con base en la opinión de los profesores expertos se diseño una prueba con lenguaje claro y preciso, no se observaron durante su aplicación usos imprevistos o inadecuados del cuestionario por lo que el CEM evaluó correctamente el constructo de la microenseñanza.